L'intelligenza artificiale diventa multimodale, multitasking e multi-personalità: DeepMind presenta Gato

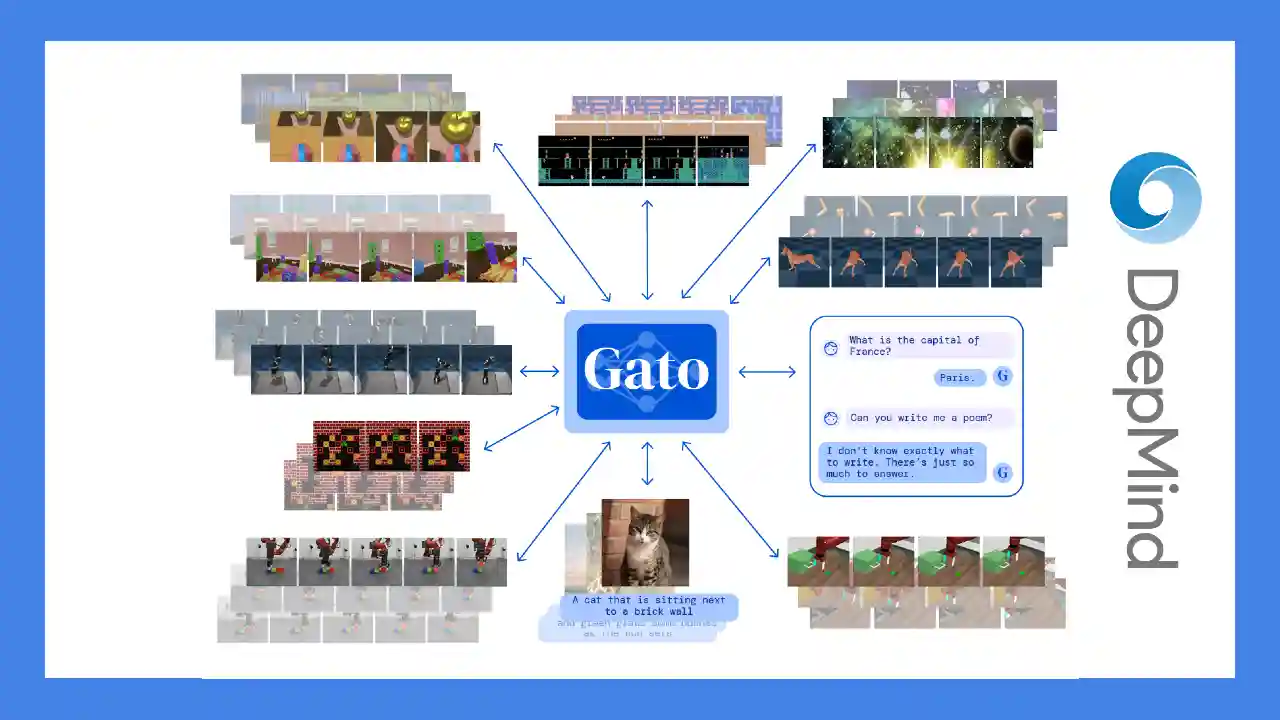

DeepMind ha presentato Gato, un'intelligenza artificiale multimodale: un unico modello in grado di eseguire centinaia di task, ad esempio il gioco, la scrittura di testi, la chat, l'elaborazione delle immagini.. fino a pilotare un braccio robotico. Il tutto generato in base al contesto.

I modelli linguistici definiti LLM (Large Language Model) come GPT-3, stanno raggiungendo livelli di precisione ed affidabilità fino ad oggi inimmaginabili. Ispirato da questo, il team di DeepMind ha creato Gato, un'intelligenza artificiale "generalista" che va oltre gli output di testo.

The agent, which we refer to as Gato, works as a multi-modal, multi-task, multi-embodiment generalist policy.

Ciò significa che lo stesso modello può, ad esempio, giocare con l'Atari, descrivere delle immagini, chattare, pilotare un braccio robotico che impila blocchi, e molto altro. L'aspetto sbalorditivo è che le tipologie di output vengono generate dal sistema in base al contesto.

Come ha affermato Scott Reed, un ricercatore di DeepMind e co-creator di Gato, la maggior parte degli attuali sistemi di intelligenza artificiale può essere applicato ad una singola attività o ad un dominio ristretto. Il significato del lavoro fatto su Gato mira a dimostrare che un singolo agente, in realtà, può svolgere centinaia di task, anche molto diversi.

Jack Hessel, ricercatore presso l'Allen Institute for AI, sottolinea che un unico sistema di intelligenza artificiale in grado di risolvere diversi compiti non è del tutto nuovo. Ad esempio, Google ha recentemente iniziato a utilizzare un modello chiamato MUM (Multitask Unified Model) in grado di gestire testo, immagini e video per eseguire attività di ricerca, di traduzioni e di associazione tra query di ricerca e immagini. Quello che fa la differenza, nel caso di Gato è la grande differenza tra le tipologie di compito e il metodo di training.

La chiave del training dei sistemi multitasking è il fatto di capire se i task si completano a vicenda. Un esempio: il sistema riceve in input l'informazione "A", e per generare l'output usa una determinata sotto-rete; allo stesso modo, il sistema riceve in input l'informazione "B" e per generare l'output usa un'altra sottorete. Addestrando le due sotto-reti separatamente si ottengono delle prestazioni.. che potrebbero migliorare se venissero addestrate insieme.

L'architettura di Gato

L'architettura di Gato non diverge da quella degli altri modelli LLM più noti (es. GPT-3), infatti si basa sui Transformer: una struttura che risale al 2017. Nel video che segue viene spiegato in dettaglio di cosa si tratta.

L'addestramento è avvenuto attraverso miliardi di esempi, che comprendono testi, immagini, ambienti simulati, sequenze, ecc.. Tutti i dati vengono trasformati in token, ovvero delle strutture dati che rappresentano le informazioni.

I think people saying it’s a major step towards AGI are overhyping it somewhat, as we’re still not at human intelligence and likely not to get there soon (in my opinion). I’m personally more in the camp of many small models [and systems] being more useful, but there’s definitely benefits to these general models in terms of their performance on tasks outside their training data.

- Matthew Guzdial, University of Alberta -

Paradossalmente, Gato è un modello più piccolo di GPT-3 (relativamente al numero parametri), e questo è stato fatto volutamente, in modo che la latenza di output fosse bassa. Tuttavia, se il modello venisse ingrandito, potrebbe svolgere qualunque tipologia di task.

La direzione è l'AGI (Artificial general intelligence)?

Molte testate si sono espresse sul nuovo modello di DeepMind, ed è apparso spesso il termine AGI, ovvero la capacità dell'AI di comprendere o apprendere qualsiasi task come farebbe un essere umano. Secondo il mio punto di vista siamo assolutamente lontani da questo concetto, e credo non sia un obiettivo.

Su questo, si è espresso anche Mike Cook (Knives & Paintbrushes) del quale riporto la dichiarazione.

I think the result is open to misinterpretation, somewhat. It sounds exciting that the AI is able to do all of these tasks that sound very different, because to us it sounds like writing text is very different to controlling a robot. But in reality this isn’t all too different from GPT-3 understanding the difference between ordinary English text and Python code. Gato receives specific training data about these tasks, just like any other AI of its type, and it learns how patterns in the data relate to one another, including learning to associate certain kinds of inputs with certain kinds of outputs. This isn’t to say this is easy, but to the outside observer this might sound like the AI can also make a cup of tea or easily learn another ten or fifty other tasks, and it can’t do that. We know that current approaches to large-scale modelling can let it learn multiple tasks at once. I think it’s a nice bit of work, but it doesn’t strike me as a major stepping stone on the path to anything.

Cosa sono le reti neurali artificiali?

Gato e anche gli altri moderni modelli LLM, sono basati su reti neurali. In generale, oggi, quando si parla di intelligenza artificiale, questo termine viene utilizzato molto spesso. Il seguente video spiega in maniera molto semplice di cosa si tratta.

Dal punto di vista matematico una rete neurale è una funzione. Ma che cavolo è una funzione? È semplicemente una relazione tra ingressi e uscite, come una macchinetta del caffè: ad ogni codice è associata una bevanda.

Per approfondire