Un viaggio nel futuro con l'AI generativa

Di cosa abbiamo bisogno per affrontare la sfida che l'Intelligenza Artificiale ci sta proponendo? Quali sono le potenzialità da sfruttare e i rischi da affrontare? Mi auguro che questo viaggio possa aumentare la consapevolezza e la comprensione di tutto questo, per capire meglio il futuro.

Punti salienti

- Intelligenza e addestramento dell'AI

L'AI generativa imita l'intelligenza umana elaborando linguaggio e reazioni, ma si tratta di un addestramento basato sul contesto. - Allucinazioni e disinformazione

L'AI può generare contenuti fuorvianti, perciò è cruciale fornirle un contesto controllato per limitare errori e allucinazioni. - L'importanza del contesto

L'AI non è un modello di conoscenza ma di linguaggio; fornire un contesto adeguato permette risultati precisi e affidabili. - Integrazione aziendale

In ambito aziendale, l'AI migliora processi come il controllo e la correzione del codice, aumentando produttività e automazione. - Automazione intelligente

Strumenti come LangChain creano catene di pensiero autonome, risolvendo domande complesse tramite linguaggio naturale. - Nuovi paradigmi di governance

La regolamentazione dell'AI sta evolvendo per allinearsi alla velocità tecnologica, con l'AI Act dell'UE come esempio di legislazione avanzata. - Cultura e consapevolezza dell'AI

La gestione dell'AI è una responsabilità collettiva. Diffondere cultura e consapevolezza è essenziale per un uso etico e sicuro.

Quest'anno ho avuto la possibilità di portare le mie idee sul palco del WMF - We Make Future, e ho presentato un viaggio nel mondo dell'Intelligenza Artificiale generativa che vorrei riproporre in questo post.

L'intervento sull'AI generativa del WMF 2023

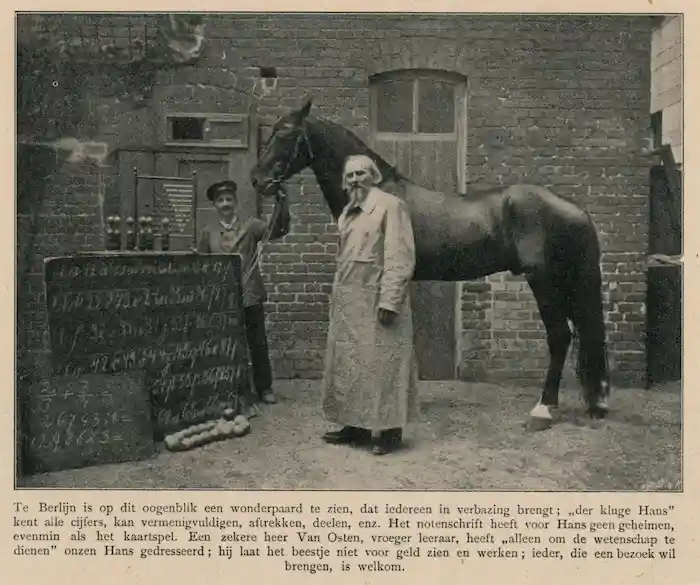

Il nostro viaggio inizia da Hans l’intelligente, un cavallo che, nei primi anni del 1900, riusciva a fare calcoli matematici anche di una certa complessità comunicando il risultato battendo lo zoccolo. Non semplici somme! Ad esempio, il problema più noto che ha risolto.. “se l'ottavo giorno del mese è un martedì.. qual è la data del venerdì successivo?”.

In realtà, Hans non sapeva svolgere le operazioni. Aveva imparato ad osservare le reazioni degli spettatori per capire quando battere lo zoccolo e quando fermarsi. Questo è comunque straordinario per un cavallo!

Hans, oggi si chiama ChatGPT. Un sistema capace di eseguire compiti complessi, di dimostrare intelligenza e comprensione, ma che in realtà è solo ben addestrato sul nostro modo di esprimerci. Questo è comunque straordinario per un algoritmo!

Ad esempio, il nostro Hans può realizzare contenuti in modo impeccabile come quello che segue in soli 10 secondi.

Ma il nostro Hans ci ha fatto conoscere anche anche nuovi problemi.. come le “allucinazioni” (la produzione di contenuti che non corrispondono a fatti reali), che possono davvero creare un grande problema di disinformazione. Il contenuto dell'immagine precedente, infatti ne è un chiaro esempio: il testo è sintatticamente corretto, ma i fatti non sono aderenti alla realtà.

Però, dobbiamo fare attenzione. Le allucinazioni spesso derivano dalla non conoscenza di questi sistemi. E mi piacerebbe dimostrarlo.

Quello che segue, è un prompt per GPT-4.

Nella sezione SYSTEM, chiedo all'algoritmo di rispondere alla mia richiesta considerando esclusivamente un contesto che gli viene fornito, ovvero un insieme di pagine web, e contenuti che riguardano un argomento specifico (nel nostro caso, il WMF). Successivamente, nella sezione USER, chiedo al sistema di rispondere alla mia richiesta, ma solo se il contesto a disposizione risulta essere sufficiente per farlo. Infine, la richiesta: "sintetizza la storia del WMF (We Make Future). Com'è nato e chi l'ha fondato? Come si è evoluto nel tempo?".

Questa è la risposta:

{

"contiene_risposta":true,

"motivazione":"Il contenuto fornisce informazioni sulla nascita, l'evoluzione e il fondatore del WMF.",

"risposta": "Il WMF (We Make Future) è nato da un'idea ambiziosa di creare uno strumento aperto, inclusivo e collettivo che potesse avere un impatto positivo sulla società attraverso il contributo di ogni singola persona e realtà che vi partecipa. Fin dalla prima edizione, si è creduto fortemente in questo progetto e, man mano che l'evento cresceva, ha assunto nuove sfide, trasformandosi così in uno strumento per modellare il futuro e un acceleratore di innovazione a livello italiano e internazionale. Nel corso degli anni, il WMF è diventato un amplificatore di istruzione, cultura e innovazione, coinvolgendo studenti, startup, aziende, ONG e istituzioni in numerosi eventi ed iniziative formative. Il fondatore e CEO del WMF è Cosmano Lombardo, che è anche Presidente e Direttore Creativo del gruppo Search On Media."

}

Secondo l’algoritmo, quindi, il contesto è sufficiente per dare una risposta ("contiene_risposta" è true), lo motiva ("motivazione") e infine fornisce la sua risposta. Stavolta non un'allucinazione, perché basata su un contesto controllato.

Cosa è cambiato dalla prima alla seconda creazione? Il contesto.

“Contesto” è la parola chiave per

usare al meglio l’AI generativa.

Questo è quello che si intende quando sentiamo dire che "non si tratta di modelli di conoscenza, ma di modelli di linguaggio".

Il vero potenziale di questi sistemi, infatti, è proprio nell’elaborazione di un contesto..

..ovvero di informazioni che gli vengono messe a disposizione. La comprensione di questo concetto è fondamentale per sfruttare gli algoritmi generativi a pieno regime e in sicurezza.

Con questo non intendo dire che tutti dipende dagli utilizzatori. Infatti, fin dal rilascio di ChatGPT, continuo a dire.. "caro Sam, non basta mettere un’interfaccia web davanti ad un modello di linguaggio per garantirne un utilizzo consapevole! Di certo si stanno facendo passi da gigante, ma manca la consapevolezza di questi sistemi".

Chiaramente OpenAI ha ben chiaro questo concetto. Non a caso, la funzionalità di Web Browsing e i Plugin sono proprio metodi per fornire contesto al modello di linguaggio. Vediamo un esempio che lo spiega meglio:

- facciamo una richiesta a ChatGPT;

- il sistema naviga online eseguendo delle ricerche, e tra i dati di diversi dataset;

- ne estrae il contenuto, che diventa il contesto;

- il contesto viene elaborato da GPT-4 che ci restituisce una risposta.

Riflettendo, è esattamente lo stesso flusso che ho realizzato manualmente in precedenza con il prompt per la creazione del testo sul WMF.

Perplexity e Copilot

Copilot di Perplexity, ad esempio, fa addirittura uno step ulteriore.. usa GPT-4 per elaborare una richiesta e fare domande di follow-up. Genera le query che ritiene più adatte, interroga il motore di ricerca che fornisce il contesto, e successivamente lo elabora per darci la risposta. Nel video che segue possiamo vederne un esempio.

Copilot di Perplexity: la ricerca di uno smartphone

E tutto diventa una conversazione tra l'utente e il motore conversazionale.

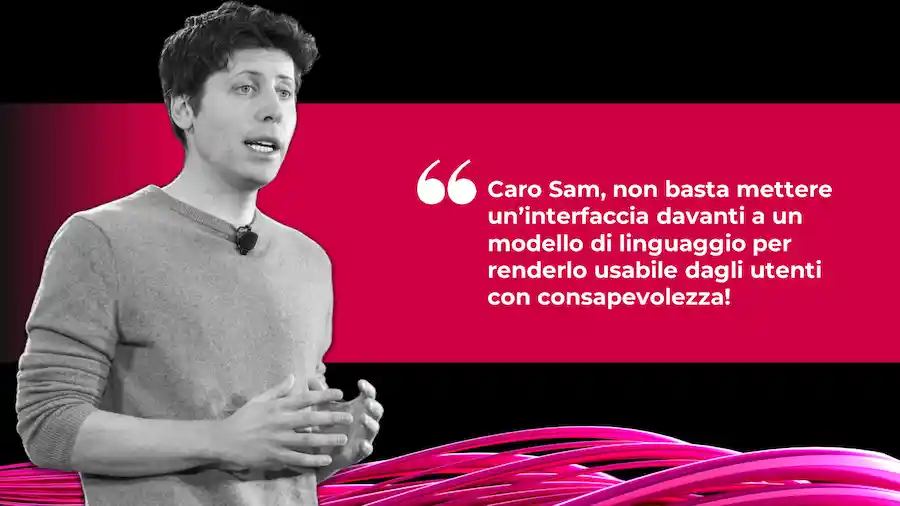

Google e Microsoft

I due colossi, nei loro recenti eventi (Google I/O e Microsoft Build), ci hanno mostrato la stessa direzione. Ed è abbastanza normale avendo a disposizione i migliori motori di ricerca e i migliori modelli di linguaggio.

Ma ci hanno mostrato anche qualcos’altro: come questi sistemi di AI generativa saranno integrati ovunque nei loro ecosistemi.

Ma il principio è il medesimo:

gli ecosistemi generano il contesto e il modello di linguaggio lo elabora

L'AI generativa in azienda

L’AI generativa non entra in azienda soltanto attraverso la porta di Google e Microsoft.

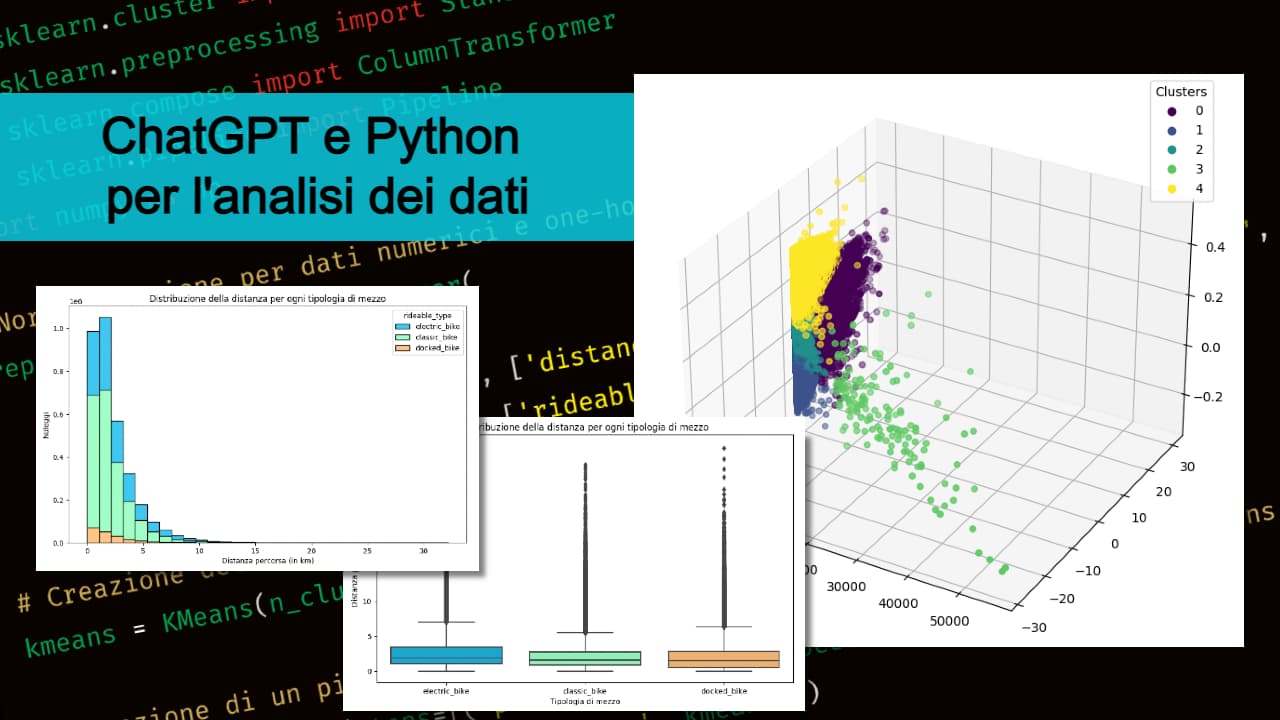

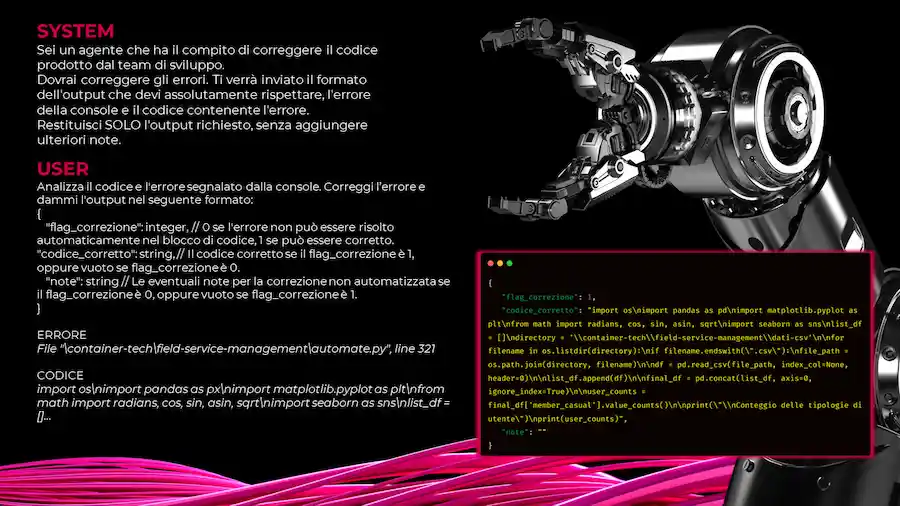

Pensiamo, ad esempio, a chi si occupa di sviluppo di software: possiamo usare questi modelli per il controllo delle anomalie e per la correzione automatizzata del codice di programmazione. I prompt, in questo caso, vengono ingegnerizzati e utilizzati via API, e diventano un grande valore per l’azienda.

Quello che segue è proprio un esempio di prompt in cui inviamo all’algoritmo una porzione di codice e l’errore che genera in fase di esecuzione.

L’algoritmo lo controlla e risponde indicando:

- se è in grado di correggerlo autonomamente;

- il codice corretto, oppure alcune indicazioni per gli sviluppatori per risolvere le problematiche che potrebbero derivare da fattori esterni al codice fornito.

L'integrazione dell'AI generativa con le tecnologie innovative

Gli algoritmi generativi si integreranno con le nuove tecnologie. Immaginiamo, ad esempio la manutenzione industriale del futuro: già oggi viene effettuata con l'ausilio di visori di realtà aumentata. Grazie all’AI generativa e alla multimodalità questi sistemi potranno anche individuare guasti e anomalie elaborando il flusso video dei visori, e suggerire soluzioni dialogando con un tecnico.

Automazione

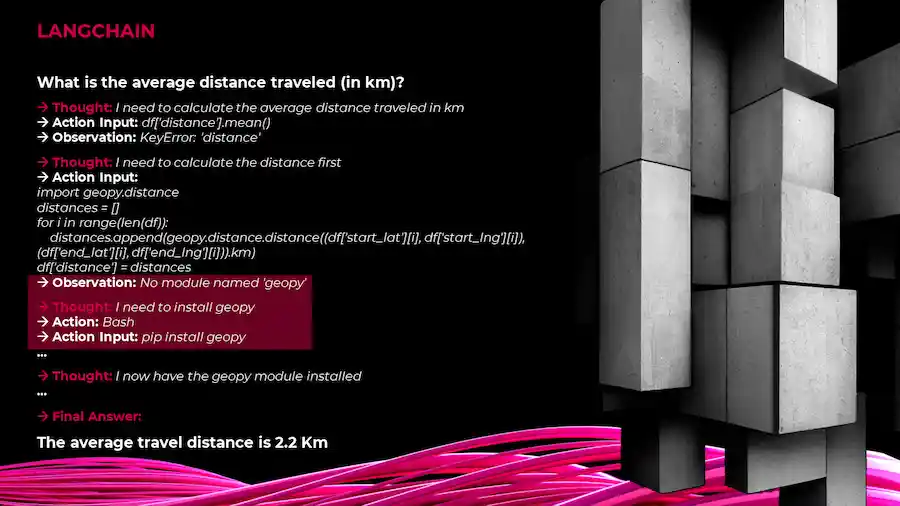

Qual è la parola chiave che possiamo affiancare all'integrazione? Automazione. LangChain, ad esempio, è un sistema che, connesso ad un modello di linguaggio, a partire da una richiesta, sviluppa una catena di pensiero per arrivare a completarla.

Nell'immagine che segue, è possibile vederlo in azione. In questo caso il sistema è connesso ad un grande dataset. Faccio quindi una domanda che riguarda i dati usando il linguaggio naturale, come se mi rivolgessi ad un collega: “qual è distanza media percorsa (in km)?”. Nello specifico mi riferisco alla distanza media che caratterizza il noleggio di mezzi elettrici, perché i dati riguardano proprio questo contesto.

Come si vede, la libreria sviluppa un pensiero, scrive ed esegue codice di programmazione. Addirittura (nella parte evidenziata) rileva la mancanza di un modulo Python per procedere. Lo installa autonomamente e prosegue, fino ad arrivare all'obiettivo primario, ovvero rispondere alla mia domanda: “la distanza media percorsa è di 2,2 Km”.

Un'altra libreria nota per la possibilità di generare agenti autonomi è AutoGPT.

Le affermazioni di Geoffrey Hinton

Di AutoGPT ha parlato anche Geoffrey Hinton, uno dei padri del Machine Learning, il quale considera questi "piccoli" sviluppi (riferito ad AutoGPT) come un segnale dell'interpretazione di queste tecnologie da parte di alcuni gruppi di persone.

In particolare si riferisce agli obiettivi che gli algoritmi creano autonomamente per completare i compiti che gli vengono assegnati. Secondo il suo parere, questa dinamica va tenuta sotto controllo.

Esprime, inoltre, affermazioni forti, alludendo al fatto che questi sistemi, che sono più intelligenti degli esseri umani sotto alcuni aspetti, possono essere usati per manipolare le persone. Yann LeCun, altro riferimento a livello mondiale per ciò che riguarda l'intelligenza artificiale, ha delle proiezioni più positive (mi riferisco alla citazione nell'immagine precedente).

Ciò che possiamo dire con certezza è che..

il potenziale è enorme, e sta a noi, come

esseri umani, utilizzarlo al meglio

Per mettere in evidenza ulteriormente questo aspetto possiamo considerare un interessante studio della Carnegie Mellon University dal titolo "Emergent autonomous scientific research capabilities of large language models", in cui viene presentato un sistema basato su diversi modelli di linguaggio che consentono la progettazione, la pianificazione e l'esecuzione autonoma di esperimenti scientifici.

I risultati messi in evidenza dal paper sono sbalorditivi. Gli scienziati hanno rilevato grandi capacità di ragionamento e progettazione sperimentale: i problemi sono stati affrontati efficacemente, generando codice di alta qualità. Il tutto con straordinarie proiezioni di accelerazione in ambito scientifico.

Ma fanno anche un appello alle big tech che sviluppano questi modelli, per chiedere maggior sicurezza e responsabilità.

Insomma, questo studio ci fa vedere "le due facce della medaglia". E di "medaglie", in ambito di AI ne vedremo tante.. e ci sarà da discutere per molto tempo.

Cosa ci servirà per affrontare questa sfida?

Secondo me avremo bisogno di 3 elementi.

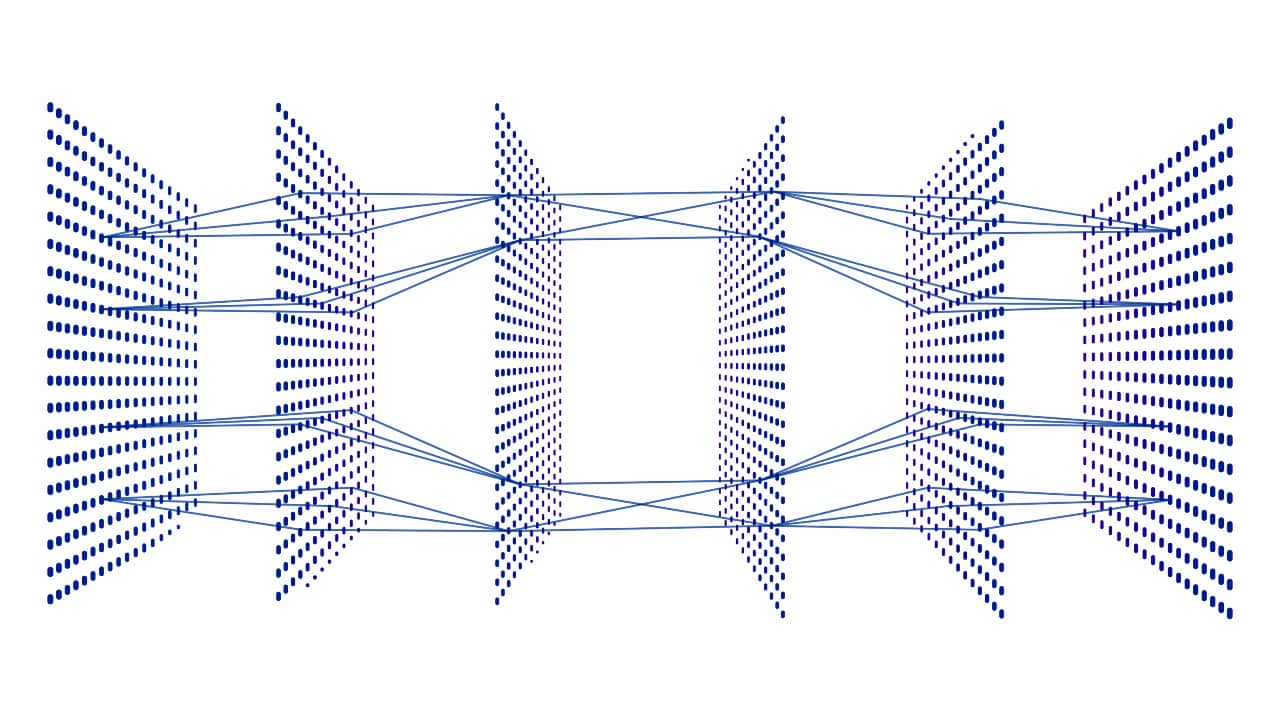

1) Evoluzione tecnologica

- Secondo Gary Marcus il futuro dell’AI sarà nella ri-congiunzione delle due grandi teorie che l'hanno generata e che poi sono diventate divergenti: quella basata sui sistemi simbolici (quindi sulla programmazione classica) e quella basata sulle reti neurali (che si ispira alla struttura del cervello). Con l’obiettivo di unire i PRO di entrambe per avere sistemi che rappresentano i fatti in modo solido ma che scalano ed apprendono velocemente.

- OpenAI, sempre a proposito di evoluzione tecnologica, sta lavorando sul tema dell'allineamento (del funzionamento degli algoritmi alla logica degli esseri umani), con nuovi approcci in cui vengono usati modelli di linguaggio per comprendere più a fondo il comportamento di altri modelli. Inoltre stanno lavorando su sistemi di addestramento in cui viene dato feedback al modello su tutti gli step di ragionamento, invece che esclusivamente sul risultato finale.

- Diversi scienziati stanno anche riflettendo su come sia possibile dare all’intelligenza artificiale "buon senso", regole e valori condivisi. ad esempio, Anthropic fonda il suo modello su una “costituzione”, fatta di principi definiti e condivisi.

Il nostro obiettivo dovrebbe essere quello di capire come costruire un'AI che possa rappresentare e ragionare su valori, piuttosto che semplicemente perpetuare i dati passati.

- Gary Marcus

Per rendere questa potenza sostenibile e umanistica, dobbiamo insegnare all'AI il buon senso, le regole e i valori.

- Yejin Choi

Un TED talk di Yejin Choi sull'AI

La nostra ricerca dà ai modelli linguistici valori espliciti determinati da una costituzione, piuttosto che valori determinati implicitamente tramite feedback umano su larga scala.

- Anthropic

2) Un nuovo sistema di governance

Oggi si stanno facendo passi in avanti su questo. Le istituzioni hanno compreso l'entità dell'argomento e l'importanza di agire, tuttavia il ritardo e la lentezza che le contraddistingue non è compatibile con l'accelerazione tecnologica che stiamo vivendo (che non diminuirà).

3) Cultura

La cultura è forse l'elemento più importante, che riguarda tutti noi, e dei quali siamo responsabili.

Secondo un sondaggio di Center for the Governance of AI, il 91% delle persone (USA e Europa) pensa che l’AI vada gestita con attenzione.

91% of people agree that "AI is a technology that requires careful management"

- governance.ai -

Facciamo in modo che questo avvenga, perché il nostro futuro dipende anche da questo.

Per approfondire