Generative AI: novità e riflessioni - #11 / 2024

Cosa sono gli AI Agents e i sistemi multi-agente? Come funziona la ricerca su ChatGPT? Aggiornamenti su Gemini, Claude, Runway e Nvidia per la content creation. Le novità di Microsoft Ignite, Brave Search, Mistral e strumenti come Screaming Frog e AISuite.

Buon aggiornamento, e buone riflessioni..

Ci vediamo al Search Marketing Connect

Nei giorni 11 e 12 dicembre, a Bologna, ci sarà la diciottesima edizione del Search Marketing Connect, che sarà orientata all'impatto dell'Intelligenza Artificiale su SEO, Analytics, ADV, Digital Strategy e Content.

Terrò due interventi:

- il primo sulla ricerca online potenziata dall'AI;

- il secondo sulle nuove architetture volte ad aumentare la qualità dell'inferenza nei modelli di linguaggio (sistemi di "reasoning" e multi-agent).

In entrambi, porterò concetti, sperimentazione e riflessioni.

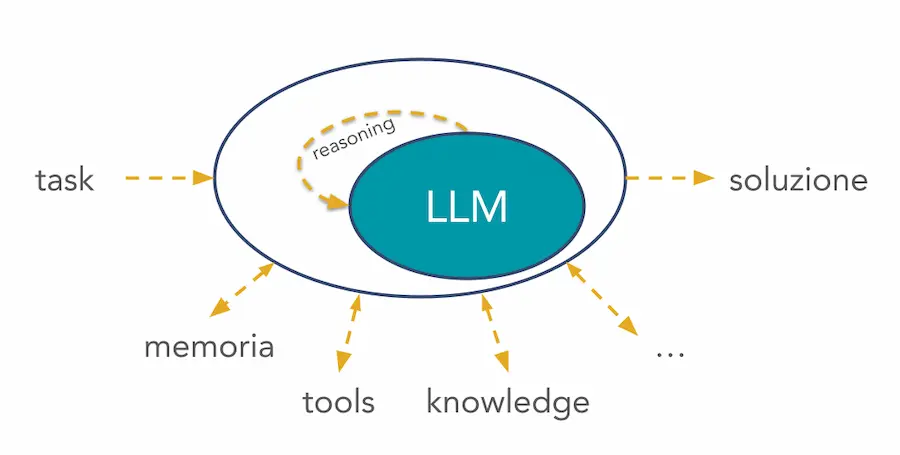

Cosa sono gli AI Agents?

Tutti parlano gli AI Agents e sistemi multi-agente. Ma di cosa si tratta?

Spiegazione semplice: un agente è un sistema che usa un LLM come motore di "ragionamento", ed è in grado di eseguire operazioni autonomamente per raggiungere l'obiettivo richiesto.

Un GPT connesso a diverse API esterne è un semplice esempio di agente: è il LLM, in base alla richiesta e ai servizi ai quali può accedere, che decide le azioni da compiere.

Qui è possibile consultare un esempio di implementazione di un semplice agente usando LangChain.

Un esempio di applicazione multi-agente

Nel video, è possibile vedere un esempio di applicazione multi-agent su AutoGen Studio, per pianificare il miglior periodo per una vacanza con determinate caratteristiche.

Un'applicazione multi-agent su AutoGen Studio

Gli agenti coinvolti sono: un proxy che riceve la richiesta, il team leader, l'esperto di meteorologia, l'esperto della Grecia e l'esperto di surf.

Ogni agente è basato su GPT-4o, e ha accesso a una knowledge specifica, o a tool che estraggono dati via API in base alle interazioni.

I vantaggi di sistemi di questo tipo: specializzazione, scomposizione di problemi complessi, scalabilità, flessibilità.

Model Context Protocol (MCP)

Anthropic introduce Model Context Protocol (MCP), uno standard che semplifica la connessione degli agenti AI a fonti di dati locali e remote.

Grazie a sistemi di questo tipo, l'LLM può collegarsi alla knowledge senza bisogno di connettori specifici, ma con "semplici" architetture client-server.

Questo permette di aumentare la precisione e di creare ecosistemi più scalabili e sostenibili, accelerando la transizione verso sistemi di AI più "agentici" e collaborativi.

La ricerca su ChatGPT

OpenAI porta su ChatGPT l'esperienza (e i feedback) di SearchGPT e le partnership editoriali nate nell'ultimo periodo.

Si basa su GPT-4o ottimizzato con nuove tecniche di generazione di dati sintetici e di distillazione che sfrutta o1.

L'ho provato. È senza dubbio migliorabile, ma mi sembra un ottimo inizio di una nuova esperienza di ricerca.

Mancano le integrazioni che siamo abituati a trovare nelle SERP di Google, ad esempio.. ma le potenzialità sono enormi.

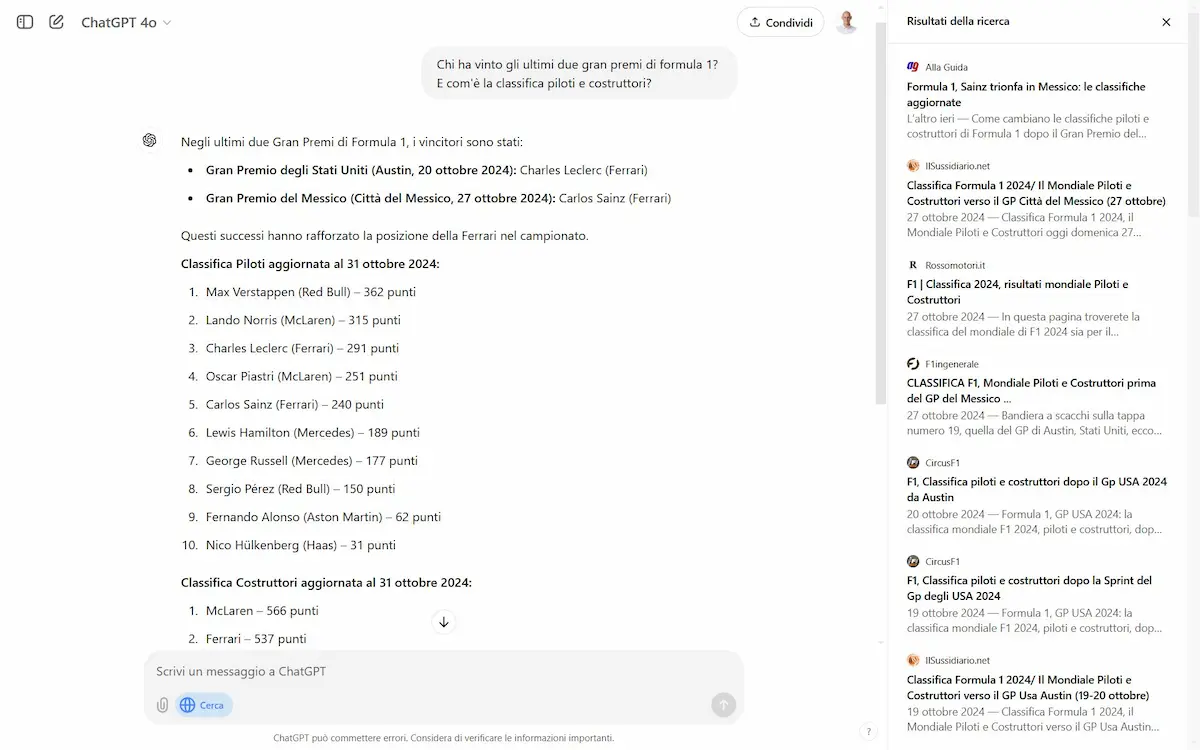

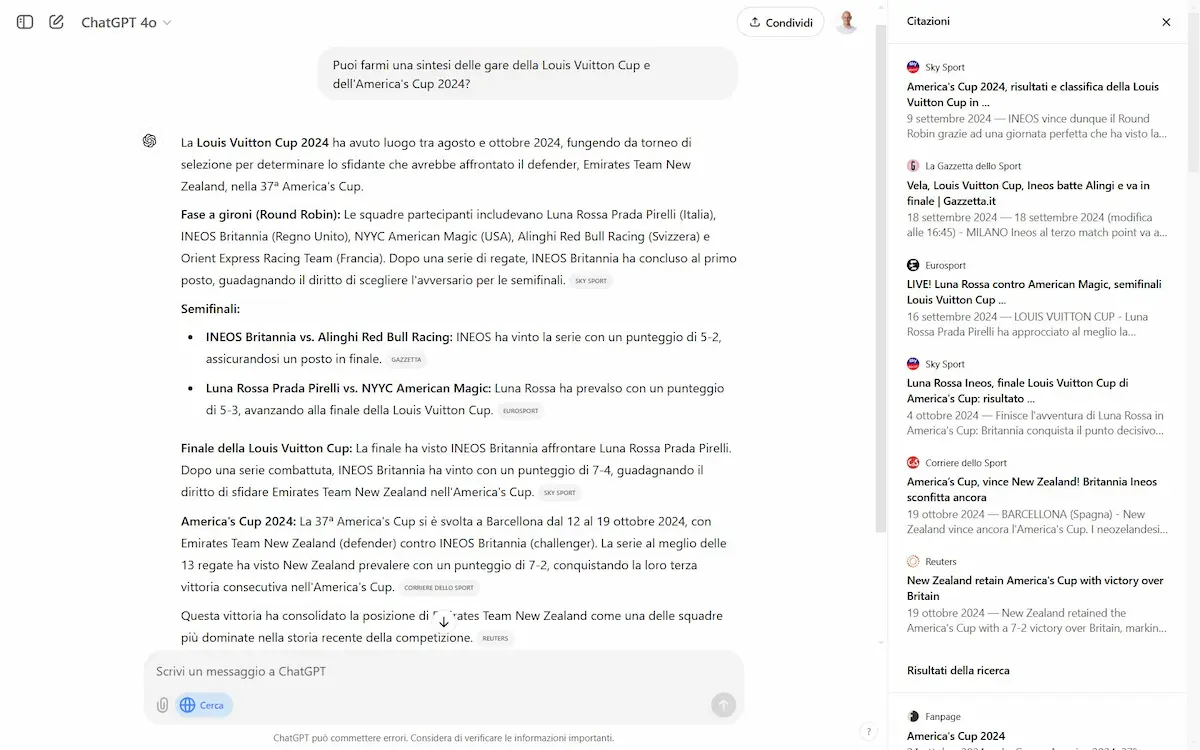

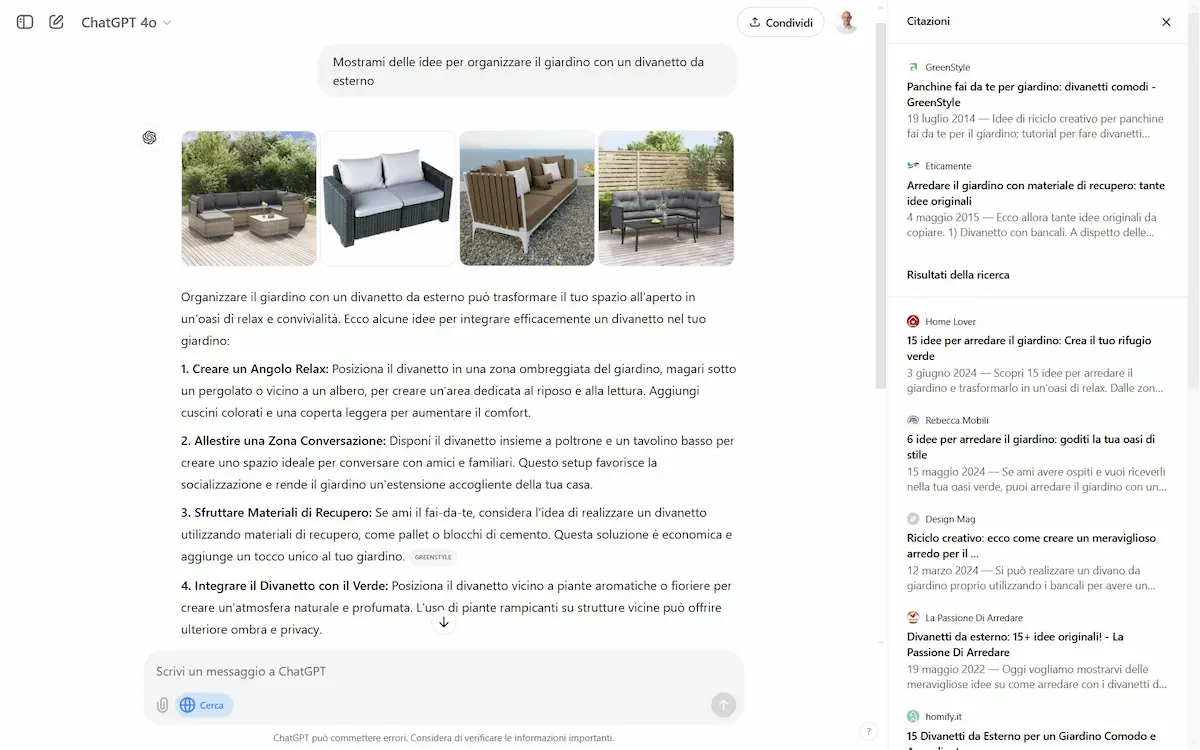

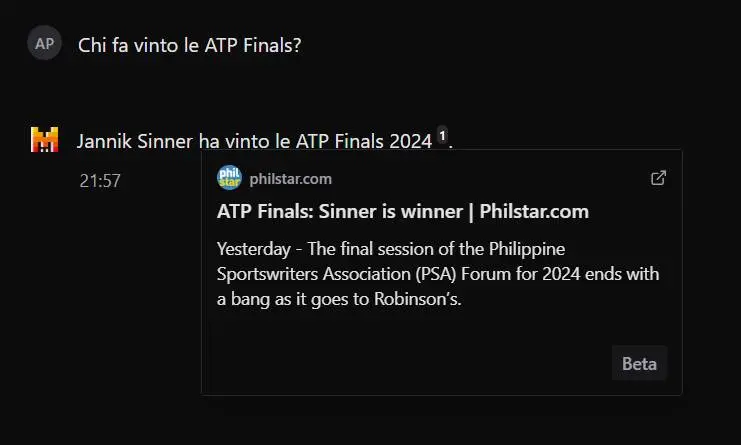

Esempi di ricerca su ChatGPT

La capacità di distillare una grande quantità di fonti in pochissimo tempo è stupefacente. La sintesi delle competizioni sportive è un esempio lampante.

E vogliamo parlare dell'estensione per Chrome che permette di rendere la ricerca di ChatGPT quella di default del browser!?

Come funziona la ricerca su ChatGPT?

Il dettaglio del video fa intuire la natura del funzionamento della ricerca di ChatGPT.

Search su ChatGPT: come funziona?

È una sorta di RAG (Retrieval-Augmented Generation): la SERP di Bing è la lista dei "documenti" che compongono la knowledge. Le informazioni vengono trasformate in embeddings, e con una query vettoriale il LLM costruisce la risposta.

Nell'area "citazioni" sono presenti i documenti della knowledge con le parti più vicine semanticamente alla query, e che, come nel RAG vengono indicate tra le fonti della risposta.

Questo cambia il paradigma di ricerca delle informazioni: la prima estrazione può essere anche poco precisa (rimanendo importante), mentre il lavoro semantico raffinato avviene in seconda battuta.

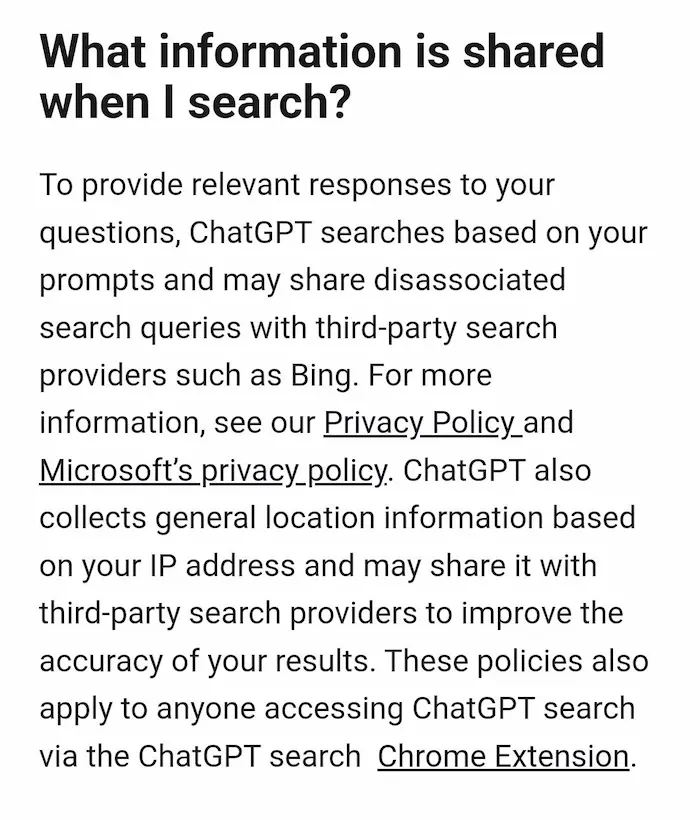

La ricerca su ChatGPT non è SearchGPT!

Ho letto diversi post in cui si afferma di aver scoperto che i risultati della ricerca di ChatGPT derivano da Bing: È COSÌ, e la documentazione lo riporta in modo chiaro (..ma bisogna leggerla!).

È stata migliorata la distillazione dei risultati, vengono sfruttare le partnership editoriali, ed è stata sfruttata L'ESPERIENZA di SearchGPT (i feedback del prototipo) per migliorare le risposte della ricerca.

Ergo: non leggiamo solo i titoli degli articoli che troviamo online. I concetti vanno approfonditi.

AI Overviews su Google Shopping negli USA

L'esperienza di AI Overviews all'interno di Google Shopping nelle SERP USA è davvero interessante.

AI Overviews su Google Shopping in USA

Google sta "spingendo" questa tecnologia dove (attualmente) non ha rivali, ovvero nelle piattaforme in cui i risultati sono guidati dai dati strutturati.

Anche se la recente integrazione dello "shopping" su Perplexity fa riflettere.

Google AI Sales Assistant

Sembra che Google, inoltre, stia testando AI Sales Assistant in SERP, raggiungibile attraverso una CTA "Shop" dopo i sitelink dei brand.

La chat permette di fare domande e affinare la ricerca dei prodotti.

Google AI Sales Assistant

I dati ben strutturati, diventano sempre di più il motore che alimenta touch point digitali. E il sito web è solo uno di questi.

SEO è anche comprendere questo aspetto, e curare feed e dati strutturati.

Lo Shopping di Perplexity

Perplexity introduce "shopping", che permette di fare una ricerca con intento d'acquisto, ottenere un listing di prodotti distillato dai risultati con informazioni dettagliate, e acquistare direttamente dalla SERP.

La ricerca può essere anche visuale.. anzi, multimodale (immagine + query testuale).

I sistemi basati sull'AI diventano sempre di più un intermediario tra l'utente e l'acquisto di prodotti e servizi.

Brave Search introduce "Answer with AI"

Una nuova funzionalità che distilla risposte in base ai risultati di ricerca, e permette una conversazione con domande di follow-up.

Il sistema si basa sui dati dell'indice di Brave e su LLM open-source e proprietari per la generazione di risposte.

Answer with AI di Brave Search

Lo stile è quello di AI Overviews di Google, con la risposta in alto e i risultati tradizionali a seguire.

Il panorama si amplia, e gli ibridi tra motore di ricerca e LLM diventano sempre di più parte dell'esperienza utente.

La versione desktop di ChatGPT

OpenAI ha rilasciato l'applicazione desktop per Windows e MacOS.

L'ho provata, e si capisce subito come la facilità di utilizzo aumenta.

La versione desktop di ChatGP

Alt + Spazio, e l'interazione è subito pronta per ricerche, azioni sui documenti, "vision" sullo schermo, e voce.

Google Search per i modelli Gemini

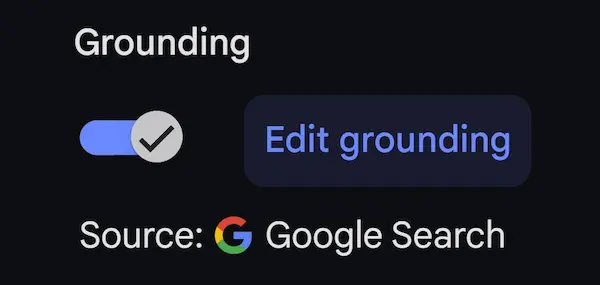

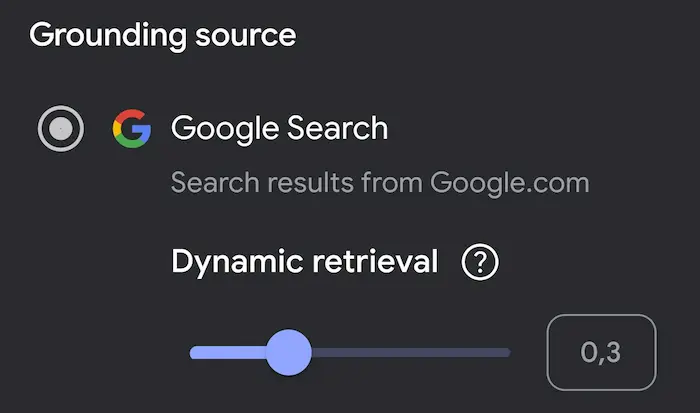

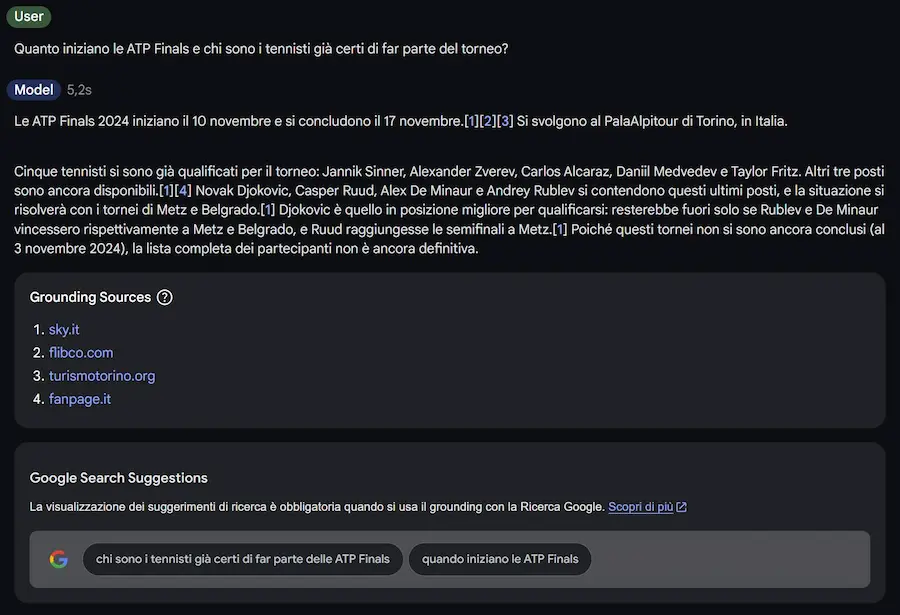

Dopo la ricerca su ChatGPT arriva Google Search per i modelli Gemini. L'ho provato.

La funzionalità si chiama "Grounding with Google Search" ed è molto simile a quella di ChatGPT.

Grounding with Google Search

Permette, però, anche si gestire il "dynamic retrieval": un parametro per impostare l'influenza del recupero dai risultati di ricerca nella risposta del modello.

Interessante anche vedere come il sistema scompone la richiesta in diverse query.

L'aspetto interessante è che sarà usabile via API, consentendo agli sviluppatori di creare applicazioni più accurate.

Sistemi di "reasoning": la qualità dell'inferenza

Durante il TED AI di San Francisco, Noam Brown (OpenAI), ha affermato:

Si è scoperto che far riflettere un bot per soli 20 secondi durante una mano di poker ha ottenuto lo stesso miglioramento delle prestazioni che si otterrebbe aumentando le dimensioni del modello di 100.000 volte e addestrandolo per 100.000 volte più a lungo.

Si stava riferendo alla tecnica usata su sistemi come "o1", che probabilmente tutti i modelli (anche di altri player) adotteranno prossimamente.

Sul palco dell'AI Festival, ho condiviso la riflessione:

La potenza di calcolo e l'accesso a grandi set di dati saranno ancora sufficienti per progredire? O forse siamo arrivati in un momento in cui la scala potrebbe non bastare più, rendendo necessarie intuizioni innovative ed evoluzioni algoritmiche?

Alessio Pomaro: AI Festival 2024

Sembra, infatti, che il focus si stia spostando sulla qualità dell'inferenza e su nuove architetture, e meno sulla scala del training (visto anche che i progressi di Orion sembrano essere al di sotto delle aspettative).

Successivamente, si dovrà cercare l'accuratezza e la "comprensione" coerente.

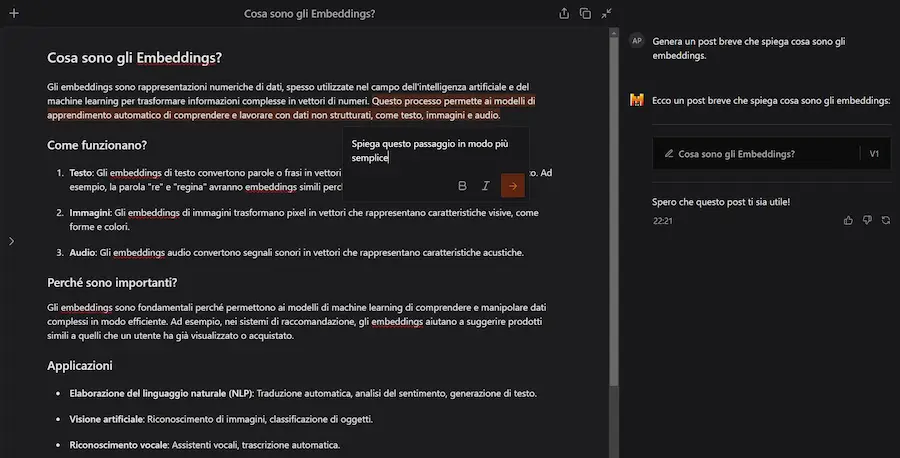

Cosa sono gli embeddings?

Sentiamo sempre più spesso parlare di embeddings: di cosa si tratta, come si generano, e come possono essere utili nei flussi operativi?

Una spiegazione semplice, con alcuni esempi di utilizzo:

In ambito SEO, ad esempio, possono essere utilizzati per creare delle redirection automatizzate per le migrazioni degli e-commerce, per gestire i 404 e per rafforzare la rete di link interni.

Facciamo anche alcune importanti riflessioni sull'importanza della consapevolezza di questi sistemi per ottenere performance.

Kling Custom Model e Suno V4

Con questo video vediamo due novità incredibili: Kling Custom Models e Suno v4.

Kling Custom Model e Suno V4

Kling ora permette un training per la coerenza dei personaggi attraverso dei video di esempio. Il video è stato creato da Alex Patrascu, addestrando Kling a riprodurre sé stesso.

L'audio del video è stato realizzato con l'ultima versione di Suno, la 4. Anche le tracce audio iniziano ad avere una qualità importante.

Il risultato è.. una parte del futuro della content creation.

Runway: Frames + Expand video

Runway ha presentato due nuove funzionalità molto interessanti (una dedicata alle generazione delle immagini).

Frames

Frames è un nuovo modello di generazione di immagini di Runway.

Le chiavi di sviluppo sembrano essere la coerenza stilistica e la fedeltà visiva. Il tutto per essere il primo step per la generazione di video sempre migliori.

Esempi di immagini generate con Frames di Runway

Le anteprime sono notevoli.

Expand Video

Expand Video è una nuova funzionalità per modificare le proporzioni dei video estendendo il frame originale e mantenendo la coerenza visiva.

A questo è possibile abbinare i movimenti della telecamera ed effetti.

Expand Video di Runway

Questo permette di creare diversi formati di video senza dover fare riprese aggiuntive.

Fugatto di Nvidia

Fugatto è un nuovo modello di Nvidia dedicato al mondo audio.

È in grado di generare e modificare qualunque tipo di mix di musica, voci e suoni utilizzando prompt basati su testo e file audio.

Esempi di funzionalità: creazione di nuovi suoni, cambiamento di emozioni o accenti in una voce, manipolazione di strumenti musicali in un brano esistente, voice-over personalizzati.

Fugatto di Nvidia

La qualità e la precisione di questi strumenti li renderà indispensabili nei flussi di lavoro.

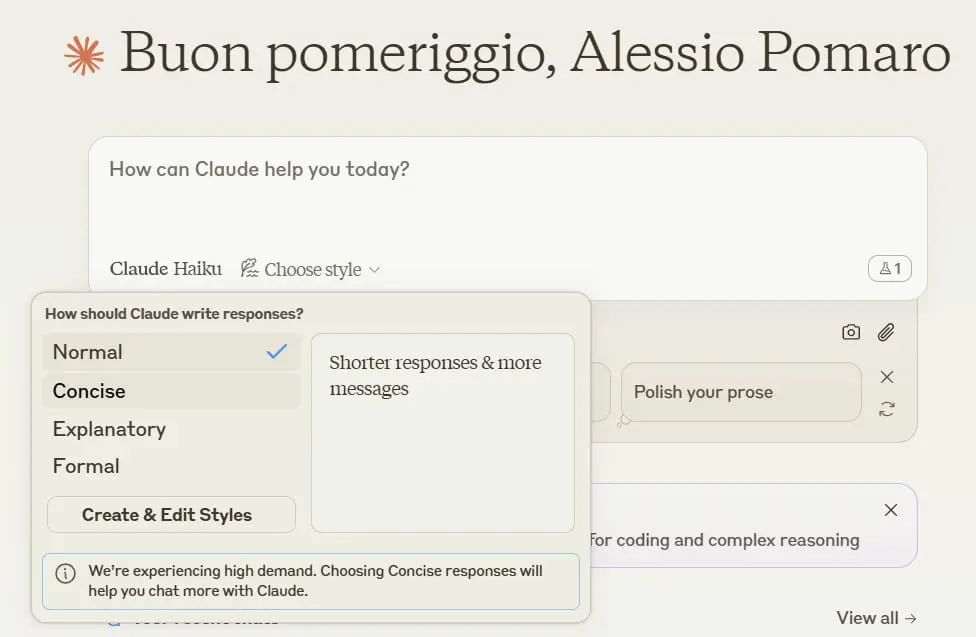

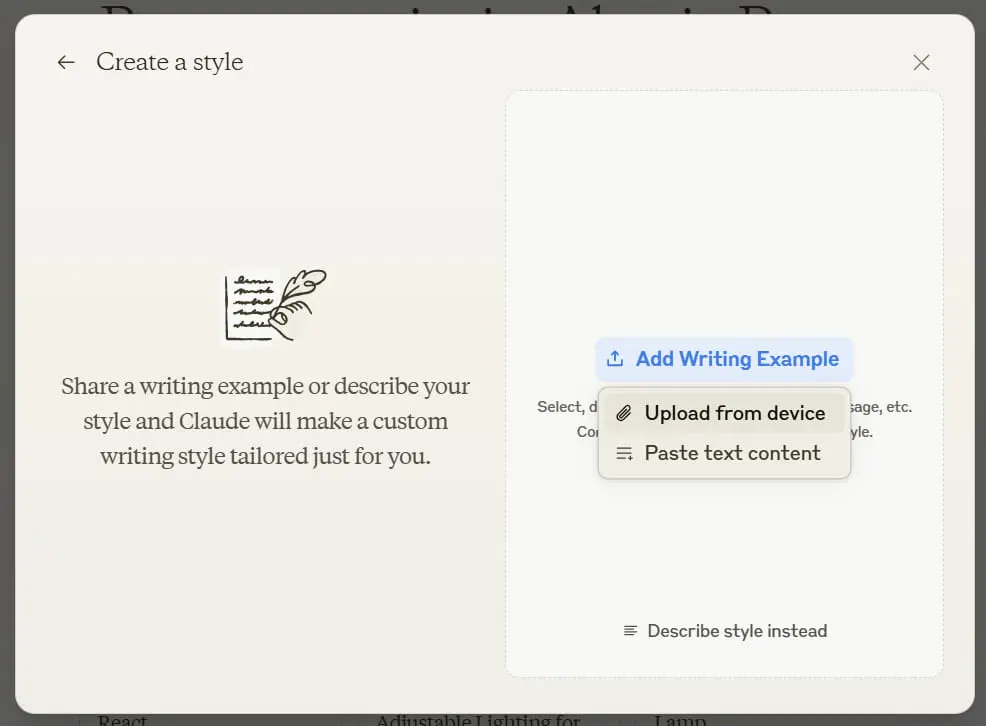

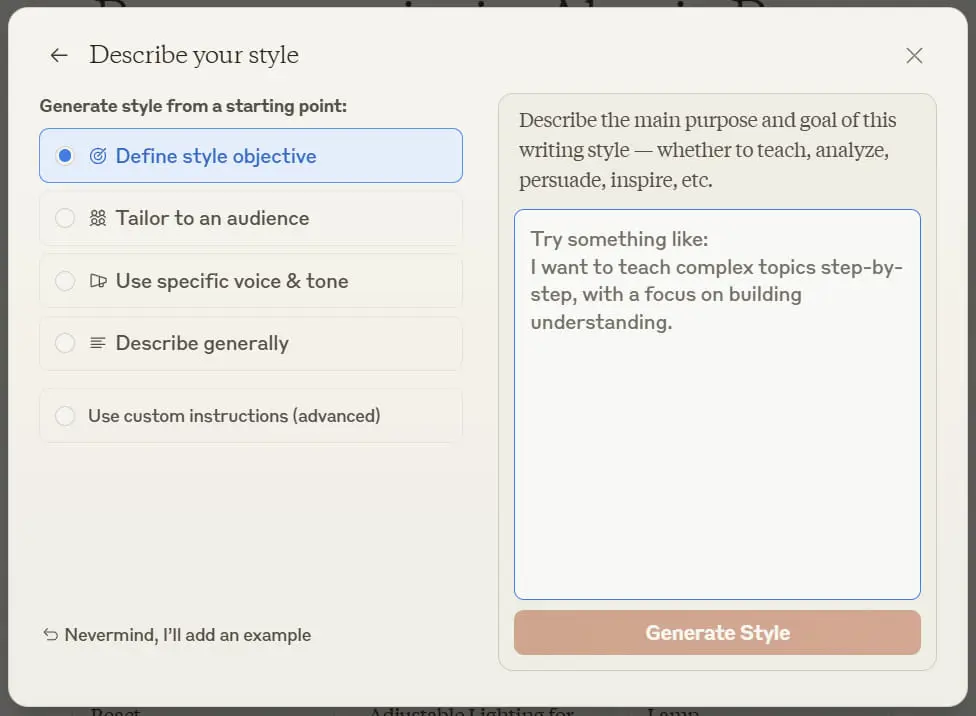

Stili personalizzati su Claude

Anthropic ha introdotto una funzionalità che permette di scegliere lo stile di scrittura su Claude.

Gli stili personalizzati su Claude

Ma soprattutto, consente di creare stili personalizzati attraverso un addestramento: caricando esempi o usando prompt descrittivi.

Aisuite di Andrew Ng

Andrew Ng ha rilasciato Aisuite nella sua repository di GitHub: un framework open che permette di usare qualunque LLM con poche righe di Python.

In pratica incapsula le chiamate API dei più noti modelli, facilitando test e prototipazione.

Ignite 2024: le novità di Microsoft

- Sicurezza e Data Governance. Nuove funzionalità in Microsoft Purview per proteggere i dati e prevenire rischi legati all'AI.

- Evoluzione di Co-Pilot. Co-Pilot diventa centrale per produttività e creatività con azioni automatizzate e agenti personalizzabili.

- Nuovi Agenti AI. Agenti specifici per moderare riunioni, gestire progetti e fornire accesso alle informazioni in tempo reale.

Un esempio è "Interpreter": un agente AI connesso a Teams in grado di tradurre in tempo reale la conversazione in qualunque lingua riproducendo la voce delle persone.

Fino a qualche anno fa lo immaginavamo.. adesso è realtà

- Co-Pilot Analytics. Strumenti per misurare l’impatto aziendale dell’uso di Co-Pilot.

- Windows 365. Nuove soluzioni per il lavoro sicuro nel cloud e aggiornamenti senza interruzioni.

- Innovazioni Hardware. Lancio di chip e DPUs per migliorare sicurezza, prestazioni e sostenibilità.

- Microsoft Fabric. Unificazione di analisi e gestione operativa con database SQL Server su Fabric.

- Azure AI Foundry. Piattaforma centralizzata per sviluppatori con modelli AI e strumenti avanzati.

- Computing Quantistico. Progresso con 24 qubit logici entangled per affrontare sfide scientifiche complesse.

Ignite 2024: le novità di Microsoft

I nuovi strumenti di Mistral

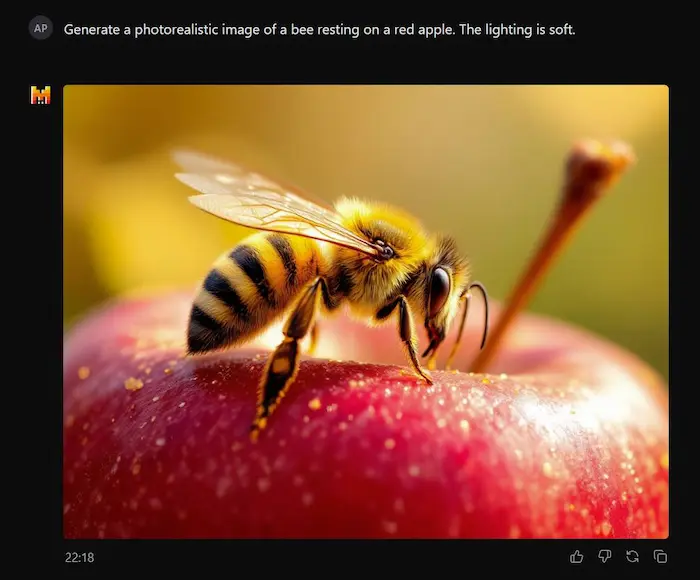

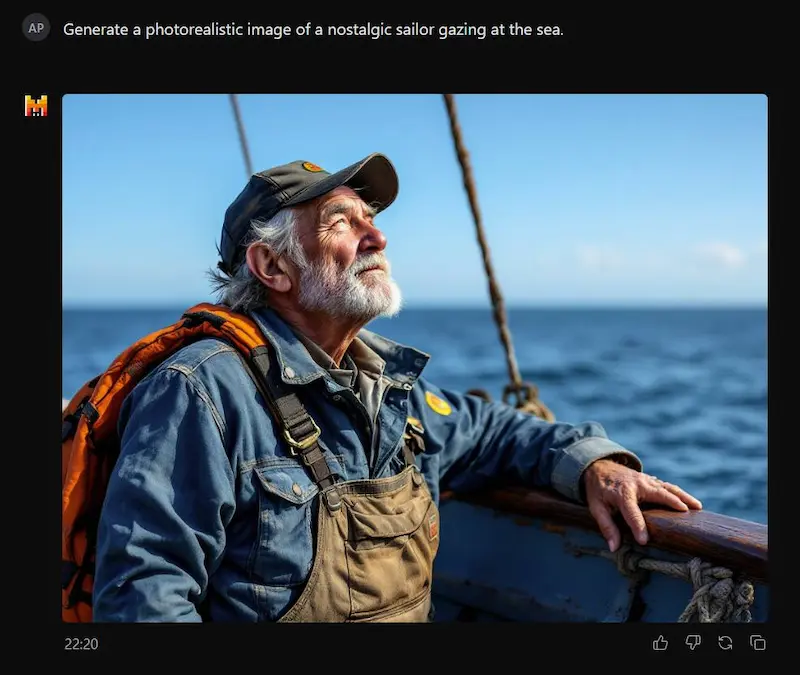

Mistral ha rilasciato una nuova versione della sua Chat, introducendo nuovi strumenti: le ricerca online, Canvas, Advanced OCR (vision) e Image Generator. L'ho provato!

- La ricerca online non è perfezionata: è lenta e ho ottenuto informazioni sbagliate. Non è specificato il motore, ma spesso i risultati derivano da una SERP in inglese. Anche se si forza la Search, non sempre esegue la ricerca.

- La generazione delle immagini è basata su Flux Pro, e questa è un'ottima notizia. Tuttavia, ci sono problemi di incapsulamento dei prompt con la lingua: meglio usare l'inglese.

- Canvas è interessante, ma ha problemi nel prompt multimodale: in un prompt ho istruito il modello per generare un post a partire da un PDF, ma ha dato errore. Al netto di questo, siamo lontani dalle funzionalità di Canvas su ChatGPT.

L'ottimo inizio di un nuovo sviluppo.

Operator di OpenAI

OpenAI, secondo Bloomberg, starebbe lavorando sul progetto "Operator", un agente autonomo in grado di controllare anche i dispositivi svolgendo compiti in modo indipendente.

Questo segue un trend già avviato da Anthropic e da Google, ma ancor prima da progetti open source come Open Interpreter.

Gli agenti autonomi sono probabilmente il prossimo passo evolutivo per l'AI, che si avvia a diventare uno strato non solo tra gli utenti e le piattaforme digitali, ma anche nei confronti dell'hardware.

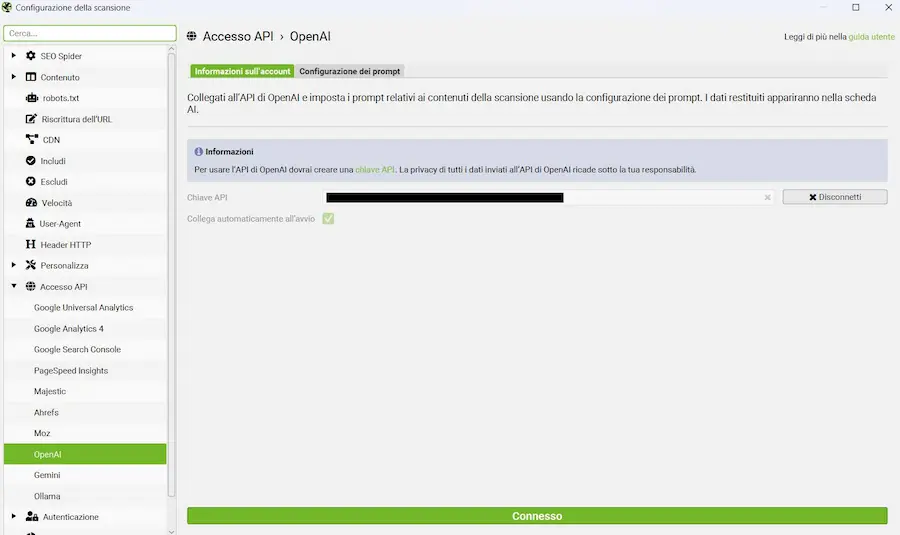

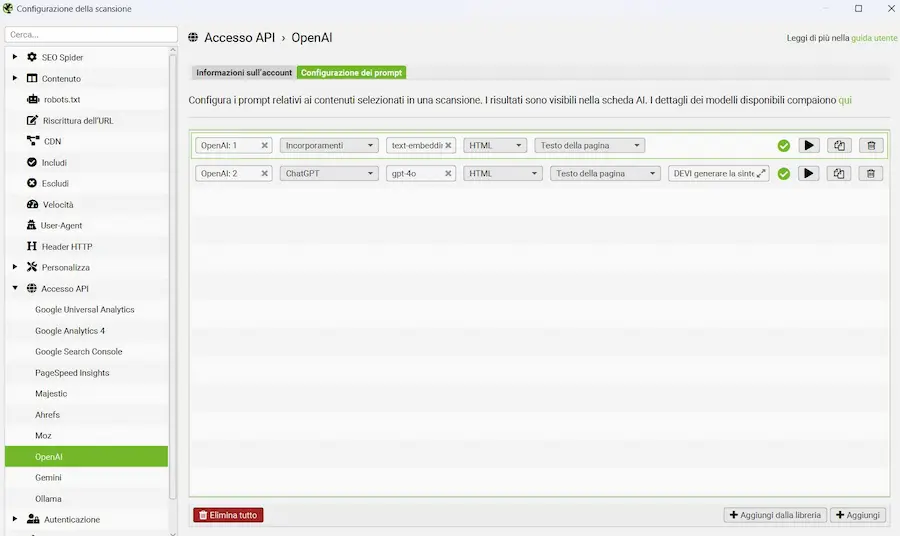

Usare i modelli di linguaggio su Screaming Frog

Screaming Frog introduce le API per l'interfacciamento con i modelli di OpenAI, Google e con Ollama.

Lavora sull'HTML salvato in fase di scansione, mentre nella versione precedente si usavano snippet JavaScript personalizzati eseguiti durante il rendering delle pagine.

È possibile generare embeddings e contenuti con prompt personalizzati su contesti selezionabili (attraverso estrattori predefiniti e custom).

L'integrazione dei LLM su Screaming Frog

COSA MANCA? La possibilità di comporre il contesto che mettiamo a disposizione del modello in base all'utilizzo di più elementi delle pagine estraibili con XPath. Questo è realizzabile con la versione JS!

Ho scritto al team di Screaming Frog, e hanno già messo la funzionalità nella roadmap di sviluppo. Ottimo!

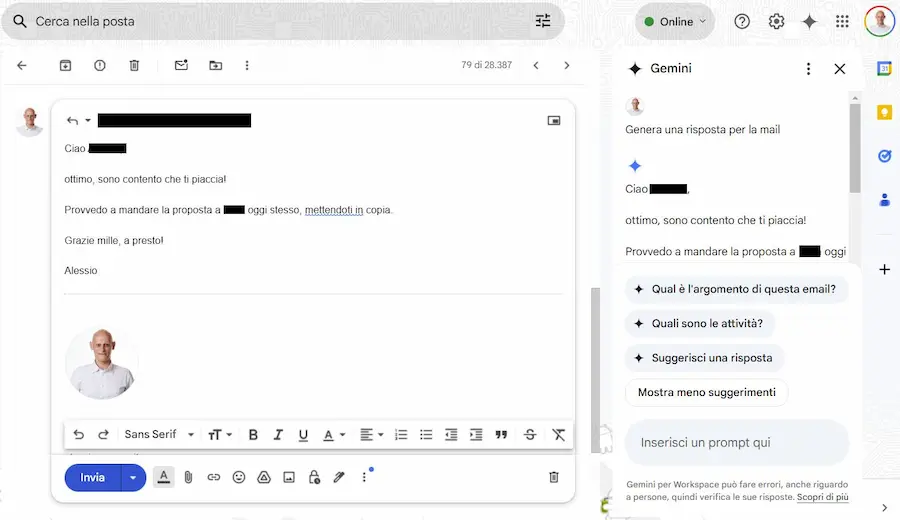

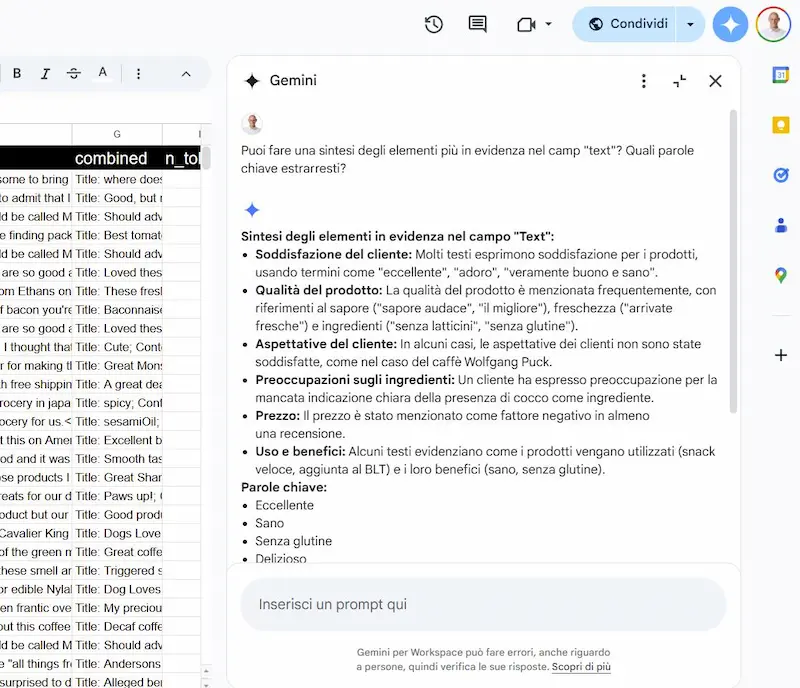

Gemini nel Workspace di Google

Google inizia ad integrare Gemini nei software del Workspace.

Negli esempi si vedono alcune interazioni su Gmail e su Drive.

Esempi dell'integrazione di Gemini nel Workspace di Google

Tutto molto interessante, anche se le performance non sono ancora ottimali (almeno per l'italiano).

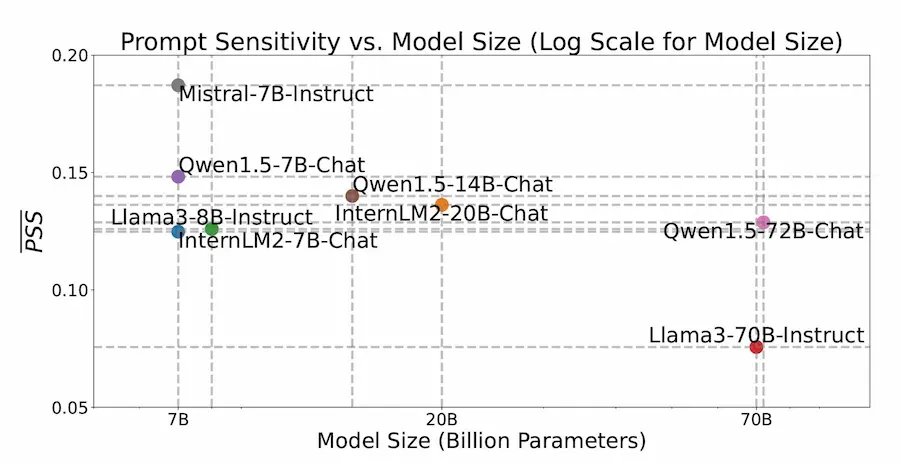

La sensibilità dei LLM nei confronti dei prompt

I LLM più grandi sono meno sensibili alle variazioni dei prompt.

Ne parla questo paper molto interessante. Ma basta fare dei test con o1 di OpenAI per rendersene conto.

Questo è ottimo perché il margine d'errore si riduce anche se le interazioni diventano più scarse, ma si riducono anche le potenzialità.

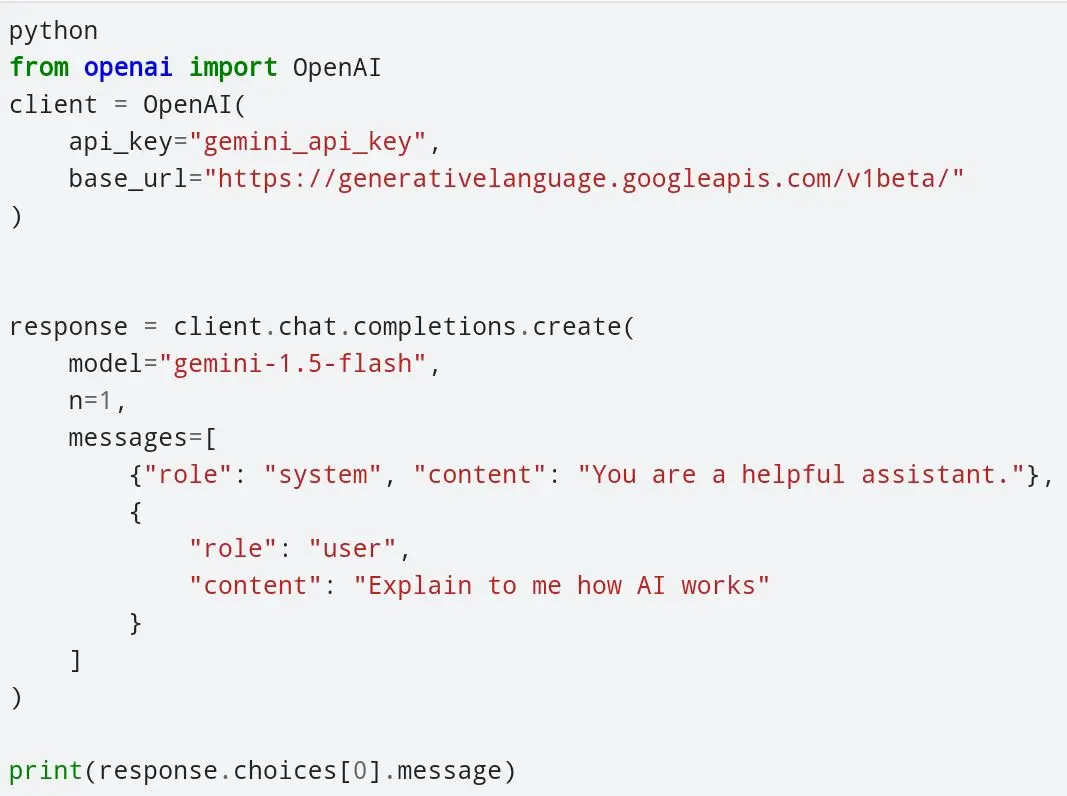

Usare Gemini con la libreria Python di OpenAI

Gemini può essere usato attraverso la libreria Python di OpenAI.

Com'è possibile? Semplice: hanno sviluppato un proxy che traduce la sintassi delle chiamate API di OpenAI nel formato richiesto dalle API di Gemini.

Mossa intelligente, perché gli sviluppatori possono switchare da un modello all'altro cambiando 2 parametri. Ma così il confronto diventa semplice.

È la dimostrazione che il formato di OpenAI sta diventando uno standard.

- GRAZIE -

Se hai apprezzato il contenuto, e pensi che potrebbe essere utile ad altre persone, condividilo 🙂