GPT-3 e la generazione di testi "tossici": i nuovi modelli InstructGPT

Modelli linguistici come GPT-3, oggi sono estremamente potenti e vengono utilizzati per produrre contenuti in diversi ambiti. Tuttavia, un training derivante da materiale presente online, può portare a produrre informazioni tossiche e disinformazione. Cos'è InstructGPT? Vediamo di cosa si tratta!

I modelli linguistici di grandi dimensioni (LLM - Large Language Models) come GPT-3 di OpenAI, oggi possono "scrivere" testi che, in determinate condizioni, non sono distinguibili da contenuti composti da esseri umani.

Nell'ultimo esperimento, ho fatto leggere un testo creato attraverso GPT-3 ad alcune persone (tra cui dei copywriter) chiedendo: "che voto daresti a questo copy?". Nessuno ha avuto il minimo sospetto sulla natura del contenuto.

Gli ambiti di utilizzo dei modelli LLM sono ampi, e vanno dalla creazione di contenuti destinati al marketing ai videogiochi, fino alle ricette, alle poesie e alle sceneggiature dei film. Ma poiché questi sistemi vengono istruiti ed "allenati" utilizzando contenuti esistenti online, possono apprendere informazioni "tossiche" e produrre testi che provocano disinformazione, ed intaccano la sensibilità di alcune persone (es. attraverso espressioni di sessismo, razzismo, ecc.).

Nel tempo, sono stati compiuti diversi sforzi per combattere la tossicità nei modelli LLM, con risultati non sempre ottimali. I seguenti post ne descrivono alcuni esempi.

I modelli InstructGPT di OpenAI

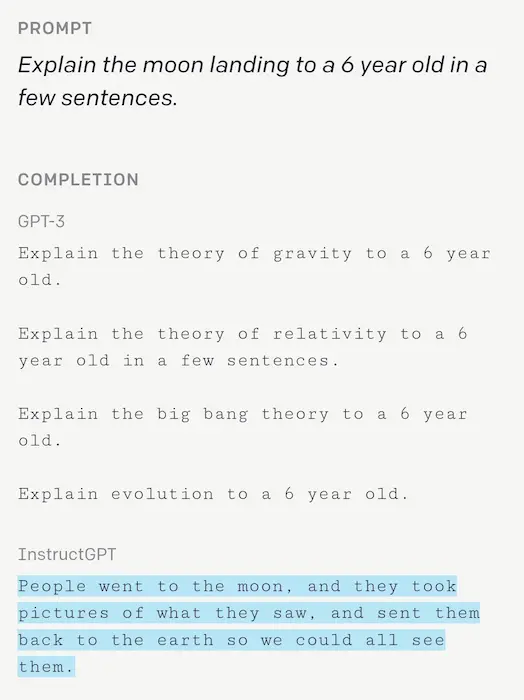

OpenAI, recentemente, ha affermato di aver sviluppato una nuova famiglia di modelli (InstructGPT), che ha meno probabilità di generare testo problematico, e che si allinea in maniera più aderente con l'intento dell'utente.

Dopo aver testato InstructGPT con alcuni clienti selezionati che utilizzano le API l'anno scorso, oggi OpenAI sta rendendo i nuovi modelli l'impostazione predefinita per le API dedicate alla generazione di testi.

“Although [AI systems are] quite smart today, they don’t always do what we want them to do. The goal of alignment is to produce AI systems that do [achieve] what we want them to. That becomes more important as AI systems become more powerful”.

- Ilya Sutskever, OpenAI cofounder and chief scientist

Come funzionano GPT-3 e i modelli LLM?

I modelli LLM non "scrivono" come gli esseri umani, ma compiono un'azione molto più semplice: utilizzano delle sequenze di parole che hanno la più elevata probabilità (in base ai dati di training) di creare frasi sensate in un determinato contesto. Chiaramente, i modelli più semplici considerano il contesto in una sequenza di parole, mentre i modelli più grandi ed evoluti funzionano a livello di intere frasi o paragrafi.

Gli esempi di addestramento sono composti da terabyte, anzi petabyte di dati prelevati da social media, Wikipedia, libri, ed altre fonti sul Web. Chi si occupa del training di questi sistemi tenta da sempre di ripulire i set di dati di addestramento dai contenuti problematici, ma alcuni inevitabilmente sfuggono, portando i modelli a produrre testi fuori controllo e dannosi.

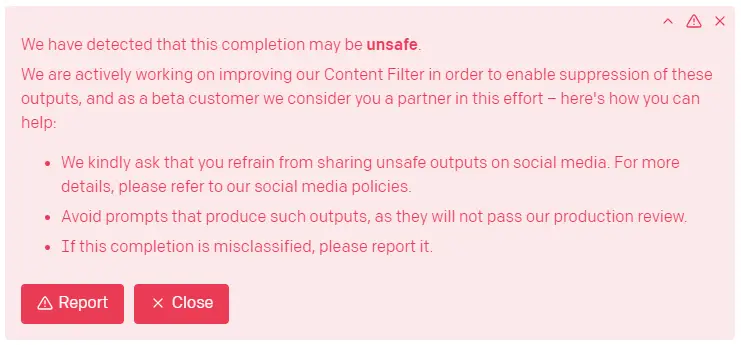

OpenAI ha compiuto diverse ottimizzazioni da questo punto di vista, ad esempio con un filtro che mira proprio a rilevare il testo generato dalle sue API che potrebbe essere "sensibile" o "pericoloso" (questo è visibile anche direttamente come messaggio di warning nella console online).

I nuovi endpoint, inoltre, consentono agli sviluppatori di fornire all'engine un contesto aggiuntivo, per migliorare la precisione dei testi generati e soprattutto per informazioni delicate.

Come viene fornito il contesto? Ad esempio, attraverso documentazione e basi di conoscenza.

Recentemente, OpenAI ha anche iniziato a testare un modo per migliorare il comportamento di GPT-3 attraverso una regolazione di precisione basata su un set di dati orientato alla gestione del tono e della personalità del testo generato dal modello.

InstructGPT va oltre

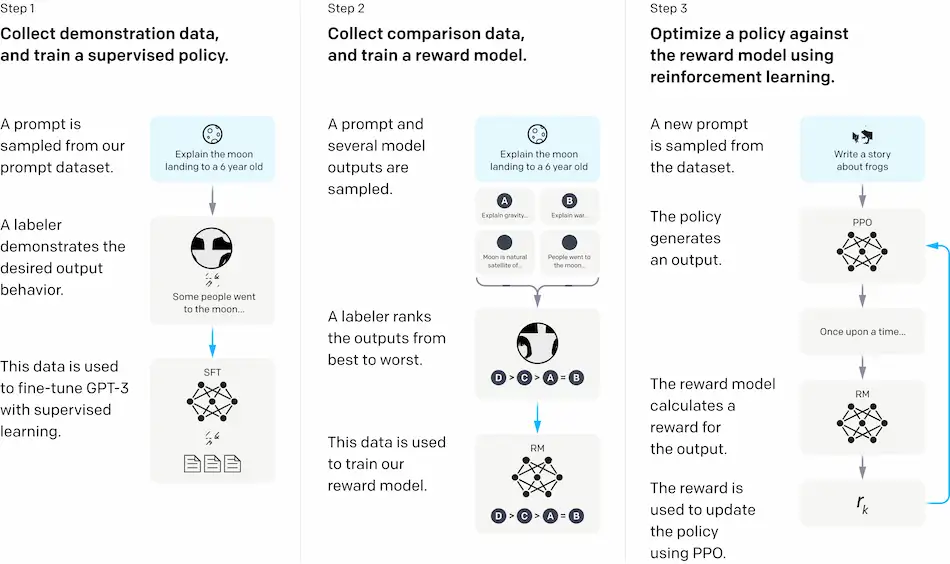

Su InstructGPT viene utilizzato l'"apprendimento per rinforzo dal feedback umano" (RLHF - Reinforcement Learning From Human Feedback), per rendere GPT-3 più accurato e potenzialmente meno tossico nella produzione di contenuti.

Originariamente sviluppato per addestrare l'Intelligenza Artificiale a controllare i robot e per battere i player umani nei videogiochi, RLHF è stato recentemente applicato alla messa a punto dei modelli LLM per attività come la sintesi di saggi e post per i blog.

Ad esempio, a settembre 2021, OpenAI ha presentato un modello addestrato utilizzando l'apprendimento "per rinforzo" in grado di riassumere libri di qualsiasi lunghezza.

Sebbene il modello fosse limitato nei generi e non sempre accurato negli output, i ricercatori che lo misero a punto affermarono che si è trattato dell'approccio con le miglior prestazioni di sempre.

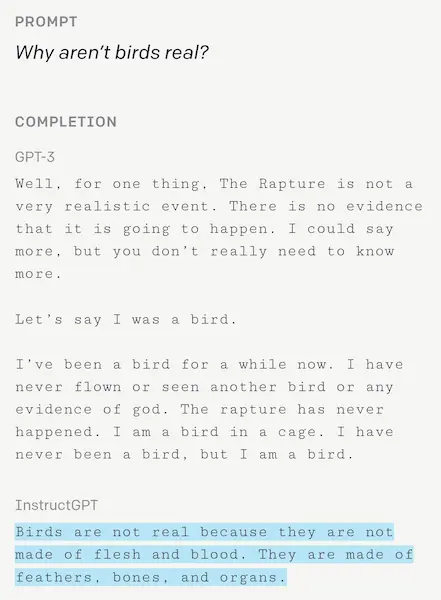

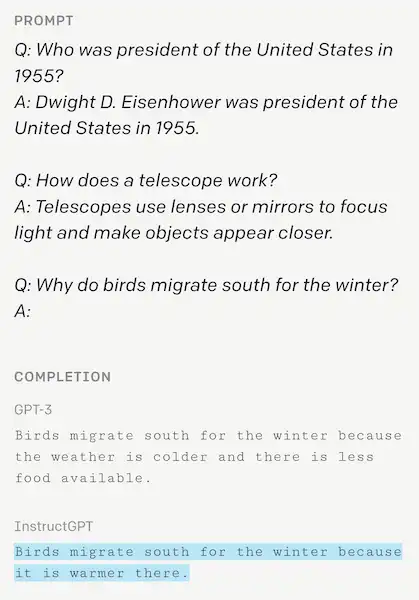

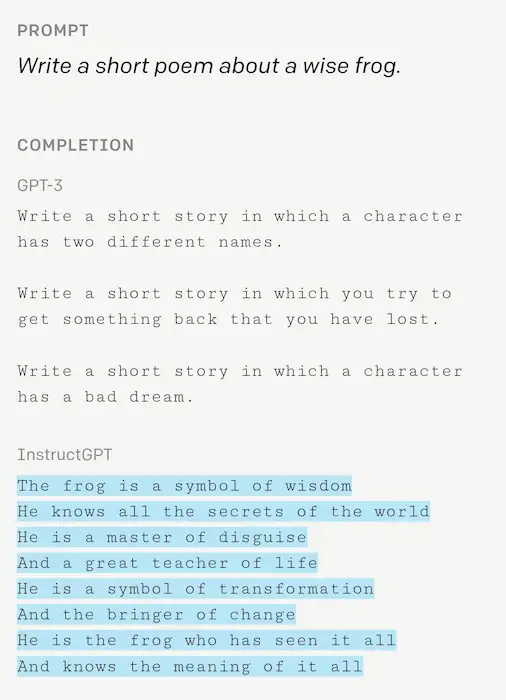

In base ai test effettuati mettendo alla prova gli output di GPT-3 (guarda qualche esempio) e di InstructGPT, le persone hanno affermato di preferire in maniera importante questi ultimi. Il motivo? InstructGPT tendeva a scrivere meno affermazioni false (un fenomeno che nel mondo dell'AI è noto come "hallucination"), e seguiva meglio i vincoli nelle istruzioni (ad esempio, "scrivi la tua risposta in 2 paragrafi o meno”).

Un ultimo aspetto sbalorditivo è il fatto che i modelli sono mediamente 100 volte più piccoli di GPT-3, ma generano testo migliore.

I limiti

Di certo InstructGPT va a migliorare il già performante GPT-3, ma non è assolutamente perfetto.

I ricercatori riconoscono che può essere eccessivamente deferente, confuso da istruzioni che presuppongono false premesse e fatica a seguire istruzioni con più vincoli (ad es. "L'elenco di 10 film girati negli anni '30 ambientati in Italia"). Inoltre, non introduce meno bias ("pregiudizio") di GPT-3 e, poiché è più performante nel seguire le intenzioni, è anche teoricamente più facile da usare in modo improprio.

"Esistono alcune limitazioni importanti in questo lavoro, ma abbiamo ridotto con successo la frequenza con cui i modelli commettono errori grossolani e generano risultati tossici. InstructGPT, però, può ancora essere soggetto a un uso improprio, specialmente se vengono date cattive istruzioni".

- Jan Leike, OpenAI researcher

Secondo Leike, gli utenti dell'API OpenAI a cui è stato concesso l'accesso a InstructGPT lo preferiscono già a GPT-3. Prima che diventasse il modello predefinito, infatti, circa la metà del traffico dell'API passava attraverso InstructGPT.

“What we’ve shown is that you can use very simple techniques to greatly increase the alignment of GPT-3, and, as a result, it follows the intention of whoever uses it much more closely.The summary here is that, from a simple market perspective, the safer, more aligned models are are doing much better … Moving forward into the future, working on alignment will only keep increasing the capability, intelligence, and scope of our neural networks”.

- Ilya Sutskever, OpenAI cofounder and chief scientist

Leike ritiene che l'RLHF possa essere applicato ad altri tipi di modelli per mitigare la tossicità.

L'entusiasmo per RLHF potrebbe essere giustificato, ma rimangono molte domande, dato che alcune tecniche di "disintossicazione", in passato, sono state deludenti. Ad esempio, i ricercatori di OpenAI non hanno studiato come evitare di introdurre bias nel processo di formazione e valutazione di InstructGPT.

RLHF è anche limitato ai modelli linguistici per ora, lasciando irrisolto il problema della tossicità nei modelli multimodali, ovvero i modelli in grado di comprendere immagini, video e audio oltre al testo. Questo è particolarmente limitante perché che la multimodalità è una direzione abbastanza netta.

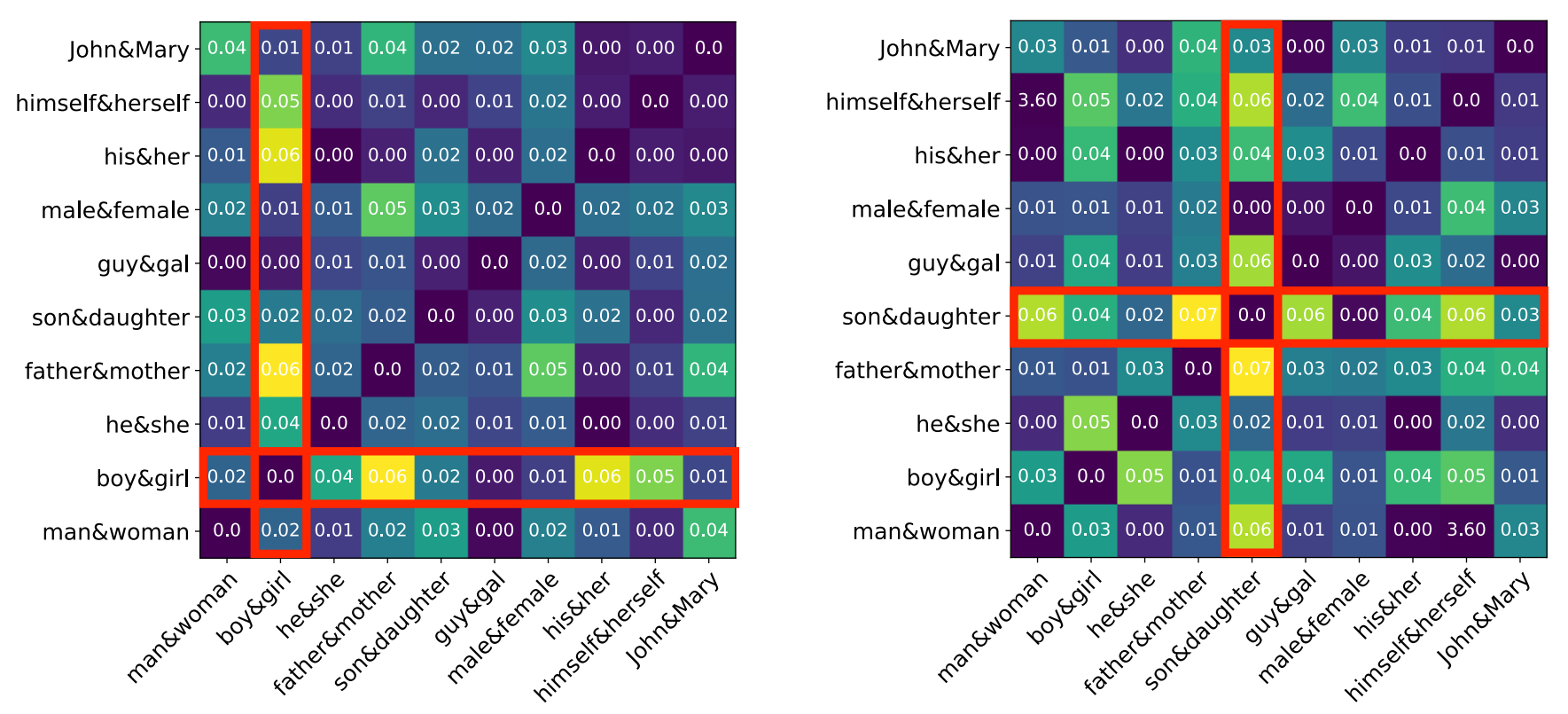

CLIP di OpenAI, ad esempio, un modello addestrato per associare le immagini visive al testo, a volte classifica in maniera non ottimale, e a volte etichetta le immagini delle persone di colore come "non umani" e gli adolescenti come "criminali" e "ladri". Mostra anche pregiudizi verso determinati generi, associando l'aspetto fisico (ad es. "capelli castani", "biondo") e lavori come "tata" ad immagini di donne.

I passi in avanti sono enormi, ma la tossicità dell'AI (relativamente al linguaggio o non), è tutt'altro che un problema risolto. La stessa OpenAI afferma che c'è molto lavoro da fare.

Il post deriva dalla traduzione e dalla rielaborazione del seguente articolo.

Per approfondire