L'inizio di una trasformazione esponenziale

Siamo all’inizio di una trasformazione esponenziale dell’AI: un momento silenzioso che precede un’esplosione travolgente. Dai primi segnali, come l’auto-ottimizzazione delle architetture, stiamo entrando in una nuova era fatta di intelligenza e azione.

Immagino che tutti abbiamo provato, almeno una volta nella vita, a preparare i popcorn.

Si mette il mais in una padella rovente e si aspetta; all’inizio non accade nulla, sembra un processo lento. Successivamente, qualche chicco inizia a scoppiare, e improvvisamente scoppiano insieme tutti gli altri.

Io credo che, per quanto riguarda lo sviluppo e l’integrazione dell’intelligenza artificiale, oggi siamo proprio in quel momento: abbiamo il mais nella padella rovente e stiamo iniziando a sentire scoppiare i primi chicchi.

L'inizio di una trasformazione esponenziale - WMF 2025

Per dirlo senza metafore, credo che siamo all'inizio di una trasformazione esponenziale.. non semplicemente veloce: esponenziale.

E iniziamo a percepire qualche segnale.

Oggi, ad esempio, è possibile usare l’AI per comprendere i complessi paper alla base dell’AI stessa. Ilya Sutskever (co-founder di OpenAI) ha recentemente pubblicato una selezione dei migliori studi scientifici che riguardano l'Intelligenza Artificiale e il Machine Learning, e ho usato NotebookLM di Google per trasformarli in un corso organizzato in lezioni, che permette di apprendere tutto molto più velocemente.

Gli strumenti migliorano, e accelerano la loro stessa evoluzione, aiutando le persone ad apprendere e creare nuove conoscenze sempre più rapidamente.

AlphaEvolve: l’AI che migliora l’AI

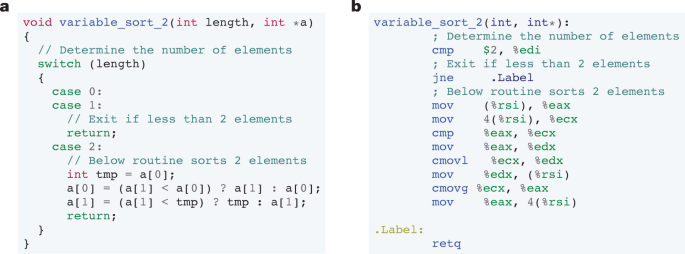

Un altro segnale importante è rappresentato da AlphaEvolve di Google DeepMind: un progetto che usa un LLM (Gemini) per scrivere e migliorare codice autonomamente.

Nulla di nuovo, giusto? Ormai siamo saturi di modelli dedicati al coding. Ma andiamo a capire meglio cosa significa.

- Ottimizzazione delle risorse. Ha permesso di recuperare in media lo 0,7% delle risorse computazionali nei data center Google grazie a nuove euristiche di scheduling.

- Accelerazione del training dei modelli. L’ottimizzazione dei kernel ha portato fino al 23% di speedup e una riduzione dell'1% nei tempi di training dei modelli Gemini.

- Scoperta di nuovi algoritmi. Ha migliorato algoritmi matematici come la moltiplicazione di matrici 4×4 con 48 moltiplicazioni (il primo miglioramento dopo 56 anni).

- Ottimizzazione del codice. Ha ottenuto un 32% di speedup nei kernel FlashAttention e un 15% nei processi di pre/post-processing dei Transformer.

- Ricerca scientifica autonoma. Ha superato lo stato dell’arte nel 20% dei problemi matematici affrontati, scoprendo nuove costruzioni ottimali

- Semplificazione dell'hardware. Modifiche ai circuiti delle TPU hanno permesso una riduzione di area e consumi, con soluzioni validate dai progettisti hardware.

Chip migliori = modelli più potenti e veloci = chip ancora migliori = modelli sempre più potenti = ...

Un chiaro segnale dell’inizio di un momento esponenziale.

Intelligenza e Azione

Andiamo ad esplorare la trasformazione che stiamo vivendo attraverso due macro aree: intelligenza, e azione.

Intelligenza

Oggi l’AI supera già le capacità umane in molti compiti specifici, come il gioco strategico, la ricerca scientifica, la diagnosi medica, le traduzioni.. e molto altro.

Qualche esempio?

1) La nuova versione multimodale del sistema di AI diagnostica di Google (AMIE) ha superato i medici di base su 29 delle 32 caratteristiche cliniche valutate da specialisti e su 7 delle 9 scale dedicate alla gestione dei dati visivi (come foto della pelle, ECG e documenti clinici), dimostrando capacità superiori anche in empatia e accuratezza diagnostica secondo attori-pazienti e medici specialisti.

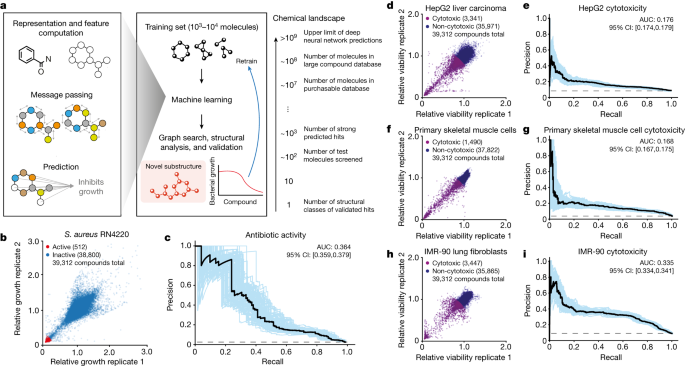

2) Un sistema di AI sviluppato da MIT e Harvard ha scoperto una nuova classe di antibiotici attivi contro batteri resistenti e selettivi per le cellule umane, dimostrando efficacia in modelli animali e superando i metodi tradizionali grazie a spiegazioni chimiche interpretabili — una conferma che l’apprendimento profondo spiegabile può rivoluzionare la scoperta di farmaci, identificando una delle poche nuove classi di antibiotici emerse negli ultimi 60 anni.

3) Il sistema AlphaDev di DeepMind ha scoperto nuovi algoritmi di ordinamento che superano gli standard umani in efficienza, portando all’integrazione di queste soluzioni nella libreria C++ standard di LLVM per la prima volta in oltre un decennio.

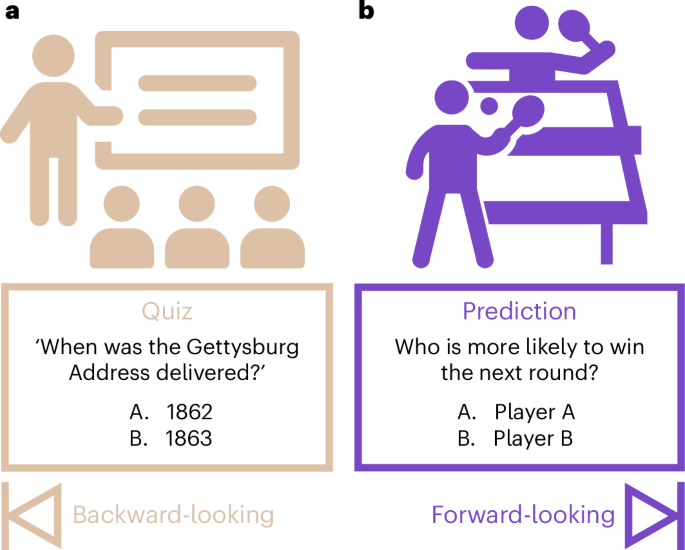

Conversazione e ragionamento

La macchina oggi è già in grado di conversare in modo indistinguibile dagli esseri umani, e di produrre dei ragionamenti.

Un recente paper mostra come GPT-4.5 di OpenAI ha superato il Test di Touring (per quanto possa essere ancora considerato interessante): chi ha fatto il test era più propenso a credere che il modello fosse umano, rispetto agli altri partecipanti umani.

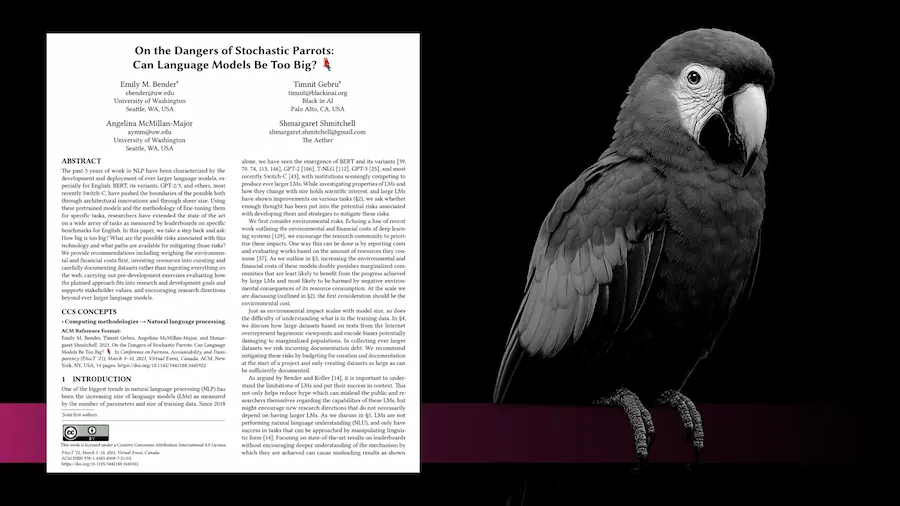

Pappagalli stocastici?

Dal 2021, grazie a un noto paper dal titolo "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?", continuiamo a ripeterci che i Large Language Model sono dei "semplici" pappagalli stocastici, che non comprendono né ragionano, ma semplicemente riaggregano sequenze statisticamente probabili di parole basate su dati di addestramento.

Paper molto più recenti, però, dimostrano che non si limitano a "rigurgitare" informazioni apprese durante il training, ma possono formulare inferenze predittive originali.

Per non parlare dei progressi ottenuti dalle moderne tecniche di "reasoning", che hanno portato a enormi progressi nei test psicometrici (che vengono usati per capire le capacità cognitive dei modelli), anche se rimangono aperte molte sfide.

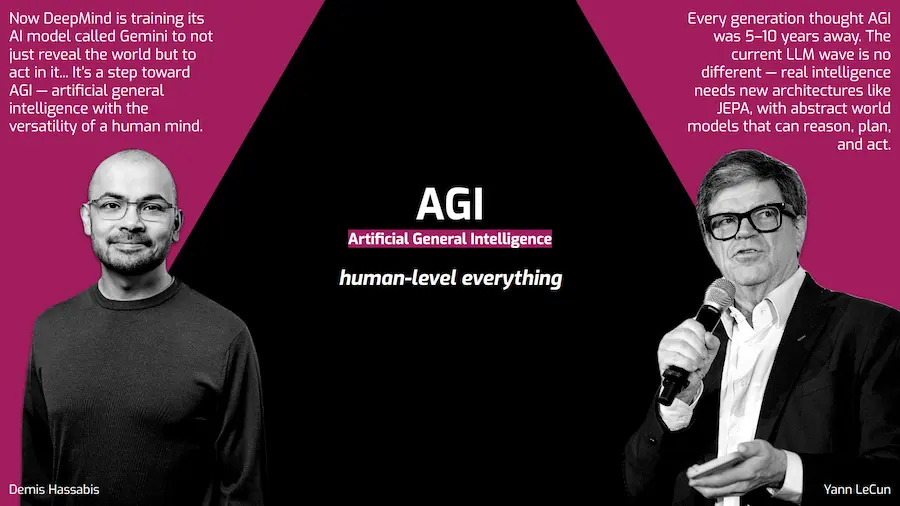

Verso un'intelligenza artificiale generale (AGI)

Il lavoro che i leader tecnologici stanno facendo sui loro modelli, ad esempio Google DeepMind con Gemini, è orientato a fare passi in avanti verso la cosiddetta AGI (Artificial General Intelligence). Un’AI in grado di superare le capacità dell'essere umano non solo su compiti specifici, ma su diversi piani: su tutti i compiti che normalmente svolgiamo.

Basteranno le tecnologie odierne per raggiungere questi obiettivi? Yann LeCun (Meta), ad esempio, pensa che serviranno ulteriori sviluppi e architetture.. e, a questo proposito, ha recentemente presentato V-JEPA 2: un modello che impara a comprendere e prevedere il mondo costruendo rappresentazioni astratte, invece di limitarsi a prevedere parole o pixel.

Ma anche Google DeepMind sta lavorando su questi concetti. Infatti, un recentissimo paper di Silver e Sutton si intitola proprio “Welcome to the Era of Experience”, che delinea il raggiungimento di AGI allo stesso modo: un’AI che apprenderà dall’esperienza diretta.. in uno stream continuo di dati reali o simulati, e non da episodi brevi e scollegati (token e pixel).

Azione

Per “azione”, mi riferisco ai concetti di Agentic AI e Physical AI.

Gli Agents sono infrastrutture che consentono alle applicazioni basate su modelli AI di interagire con sistemi esterni, attraverso API dedicate e nuovi protocolli come MCP (Model Context Protocol), e di compiere azioni.

E ormai, esistono server MCP per connettere agenti a qualunque applicazione esterna.

Visa sta addirittura sviluppando Intelligent Commerce, che permetterà agli agenti di acquistare direttamente per conto nostro.

Visa - Intelligent Commerce

Nel prossimo futuro, l'AI diventerà sempre di più un mediatore non solo delle nostre scelte, ma anche delle nostre azioni.

Physical AI

E se i modelli di AI potessero produrre come output non solo testo o chiamate API, ma anche azioni fisiche?

Questi robot sono controllati da Gemini Robotics: una versione evoluta del modello Gemini, lo stesso che usiamo nella chat di Google. Ma invece di restituire solo risposte testuali, interpreta immagini e istruzioni e le trasforma direttamente in azioni nel mondo reale: afferrare oggetti, piegare carta, versare liquidi.

Gemini Robotics: azioni robotiche guidate da istruzioni vocali

È questo che intendiamo per Physical AI: l’intelligenza artificiale che non solo "pensa", ma agisce nel mondo fisico.

Questo è un altro esempio, un robot umanoide di Boston Dynamics, che si muove nello spazio e svolge mansioni autonomamente.

Un robot umanoide autonomo di Boston Dynamics

Robot che possono essere addestrati direttamente mostrando loro le mansioni da svolgere. Questo è Gr00t N1 di Nvidia, un sistema che parte dalla dimostrazione di azioni svolte da un essere umano, usa un ambiente virtuale di simulazione per produrre enormi quantità di dati sintetici, con i quali viene addestrato il robot, che sarà poi in grado di agire autonomamente.

Gr00t N1 di Nvidia

Due anni fa si diffuse online questa immagine..

Oggi, probabilmente, ci fa ancora sorridere, ma non sembra più uno scenario così lontano e improbabile.

Un momento "popcorn"

Forse, dopo questo piccolo percorso, è un po' più chiaro perché dicevo che siamo in un “momento popcorn”.. ovvero in un inizio di trasformazione esponenziale.

Il grande tema è che dobbiamo agire prima possibile per poterlo gestire al meglio.

Perché se non mettiamo il coperchio alla padella appena buttiamo il mais, presto ci ritroveremo con la cucina che sarà un completo disastro.

Come gestire la trasformazione

Quali sono gli "ingredienti" della "ricetta" che ci permetterà di gestire la trasformazione che stiamo vivendo? Ho provato a sintetizzarli, suddividendoli per "attori coinvolti".

1) Le persone: ognuno di noi

- Dobbiamo diventare consapevoli prima possibile di questa trasformazione. Come? Usando la tecnologia (ormai abbiamo mille possibilità di farlo), per comprenderne il potenziale.

- Dobbiamo alzare l’asticella della dinamicità in ambito lavorativo, perché quello che ci viene richiesto oggi è un continuo sviluppo di nuove competenze: legate all’AI, ma anche complementari.

Le soft skill diventano sempre più hard.

2) Le aziende

- Oggi sentiamo parlare dell'adozione di strategie “AI-first”.. con affermazioni forti da parte di importanti aziende tecnologiche. Che successivamente fanno marcia indietro, per poi provare ad accelerare nuovamente: è chiaro che siamo in un momento di transizione..

- ..e in un momento di transizione, diventano fondamentali percorsi di re-skilling e up-skilling strategici, per facilitare la dinamicità che viene richiesta alle persone, e una pianificazione accurata per evitare il rischio di effettuare scelte troppo brusche che possono diventare dannose nel lungo periodo.

3) Le istituzioni

Dovranno mettere l’ingrediente della governance, attraverso:

- politiche e strategie per preparare la società a un mondo che sarà diverso, e non solo in ambito lavorativo;

- la gestione dello sviluppo tecnologico, per regolarne l’integrazione nella società in modo che sia sostenibile.

4) I leader tecnologici

Dovranno lavorare sulla trasparenza e l’interpretabilità per i modelli che sviluppano, in modo da renderli usabili in ogni settore, eliminando o riducendo le "zone grigie" che caratterizzano queste tecnologie.

Tutti i leader stanno lavorando a questo ingrediente, e Dario Amodei, CEO di Anthropic ne parla in un post molto interessante.

Inoltre, Anthropic ha anche condiviso recentemente uno strumento open source che traccia i circuiti interni dei LLM per individuare il processo che determina l’output.

Questa è la ricetta.. e ci fa capire un concetto importante.. ovvero che il cambiamento è, e rimarrà sempre, un’impresa comune.

La scelta è nostra

Il progresso tecnologico non si fermerà, e il nostro mais, nella padella rovente, scoppierà.

Sta a noi, collettivamente, attraverso delle scelte consapevoli, far sì che possiamo gustarci i popcorn serenamente sul divano.. invece di dover passare tutta la serata a ripulire la cucina.

- GRAZIE -

Se hai apprezzato il contenuto, puoi

contribuire al progetto con una donazione 🙂