Intelligenza artificiale: dai modelli ai sistemi intelligenti

Dalla corsa al “modello migliore” alla rivoluzione dei sistemi intelligenti: perché il vero vantaggio competitivo oggi non è l’LLM, ma l’orchestrazione di agenti, processi AI-first e context engineering. Casi reali, multi-agenti e uno sguardo ai world model che cambieranno tutto.

È tempo di spostare il nostro orizzonte. Serve un percorso che non si limita a osservare la superficie scintillante dell'Intelligenza Artificiale, ma che scende nelle fondamenta di come questa tecnologia sta cambiando strutturalmente il nostro mondo. Partiamo da ciò che conosciamo bene, i modelli di AI, per arrivare a una destinazione che stiamo appena iniziando a intravedere:

Sistemi complessi che mirano non solo a processare dati, ma a comprendere il mondo reale.

Intelligenza artificiale: dai modelli ai sistemi intelligenti

Il mito del "modello migliore"

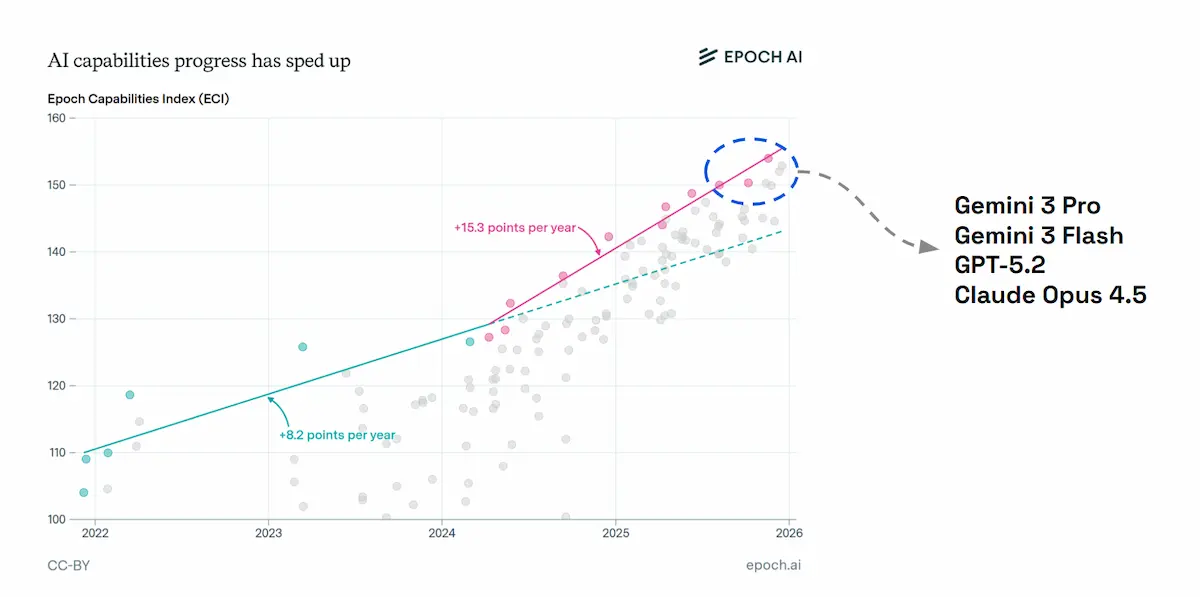

Negli ultimi anni, il dibattito pubblico e tecnico è stato dominato da una "corsa agli armamenti" sui modelli. Ci siamo chiesti chi avesse il LLM (Large Language Model) più performante, chi avesse il punteggio più alto sui benchmark. Ma se guardiamo i dati oggi, nel 2026, la realtà è cambiata drasticamente.

I modelli stanno diventando delle commodity.

Se prendiamo GPT-5.2, Gemini 3 Pro o un Claude 4.5, a parità di classe, le performance sono ormai comparabili. Ho condotto personalmente dei test in diversi flussi produttivi: ho provato a sostituire il "motore" sottostante alle nostre applicazioni, passando da un provider all'altro, e il risultato è stato illuminante. La valutazione della qualità dell'output è rimasta ottimale e costante.

Questo ci porta alla prima grande verità di questo viaggio: il vantaggio competitivo si è spostato.

Non vince più chi ha accesso al modello migliore, ma chi riesce a convogliare quell'intelligenza grezza in capacità operativa.

Non stiamo vivendo una rivoluzione di modelli, ma una rivoluzione di sistemi.

Tappa 1: Shift (il cambio di prospettiva)

La prima tappa richiede un cambiamento mentale radicale. Fei-Fei Li ha sintetizzato perfettamente questo momento storico.

“In passato, le aziende competevano sulla scala. In futuro, competeranno sull'intelligence”.

Tuttavia, c'è un malinteso di fondo su cosa significhi "integrare l'intelligence".

Molti pensano che integrare l'AI significhi semplicemente "wrappare" qualche chiamata API di OpenAI o Google all'interno del proprio software esistente. La risposta è un secco NO. Integrare l'AI non significa invocare un'API.

Questa interpretazione superficiale è il motivo per cui molte startup AI falliscono: costruiscono interfacce, non sistemi. Un sistema vero richiede architettura, affidabilità e, soprattutto, un nuovo design dei processi.

Tappa 2: Design (pensare "AI First")

La seconda tappa riguarda il Mindset. Satya Nadella aveva previsto che ogni azienda sarebbe diventata un'azienda AI non aggiungendo tecnologia, ma riprogettando il modo di lavorare.

Ma cosa significa, nella pratica, "pensare AI First"?

Non significa usare l'AI per fare le stesse cose di prima, solo più velocemente. Significa mettere in discussione il processo stesso, ponendo l'AI al centro.

È un cambio di paradigma che si gioca sulle domande che ci poniamo:

- Approccio vecchio: "Come possiamo automatizzare la creazione di questo report?"

- Approccio AI First: "Quali decisioni dovrebbe prendere questo report per noi, autonomamente?"

È una sfumatura sottile, ma potentissima. In azienda, applichiamo questo concetto attraverso un metodo rigoroso che unisce creatività e solidità ingegneristica..

- Sperimentazione Agile: le unit di Consulting e R&D ideano POC (Proof of Concept) su ambienti flessibili come Google Colab.

- Coding Assistito: usiamo l'AI stessa (con sistemi come Codex o Antigravity) per convertire le logiche sperimentali in codice strutturato e repository GitHub in tempi record.

- Industrializzazione IT: il team IT subentra per trasformare il POC in un prodotto robusto, sicuro e scalabile.

Il risultato: non si tratta di demo isolate, ma processi interni che evolvono fino a diventare nuovi prodotti SaaS per i nostri clienti.

Tappa 3: Orchestra (dagli agenti ai team)

Entriamo nel cuore della trasformazione tecnica: l'orchestrazione. Andrew Ng ci ha introdotto al concetto di AI Agentica: sistemi che non si limitano a rispondere, ma pianificano, agiscono, ragionano, riflettono e si adattano. Usciamo dall'era dei "prompt intelligenti" per entrare in quella dei sistemi che operano nel tempo.

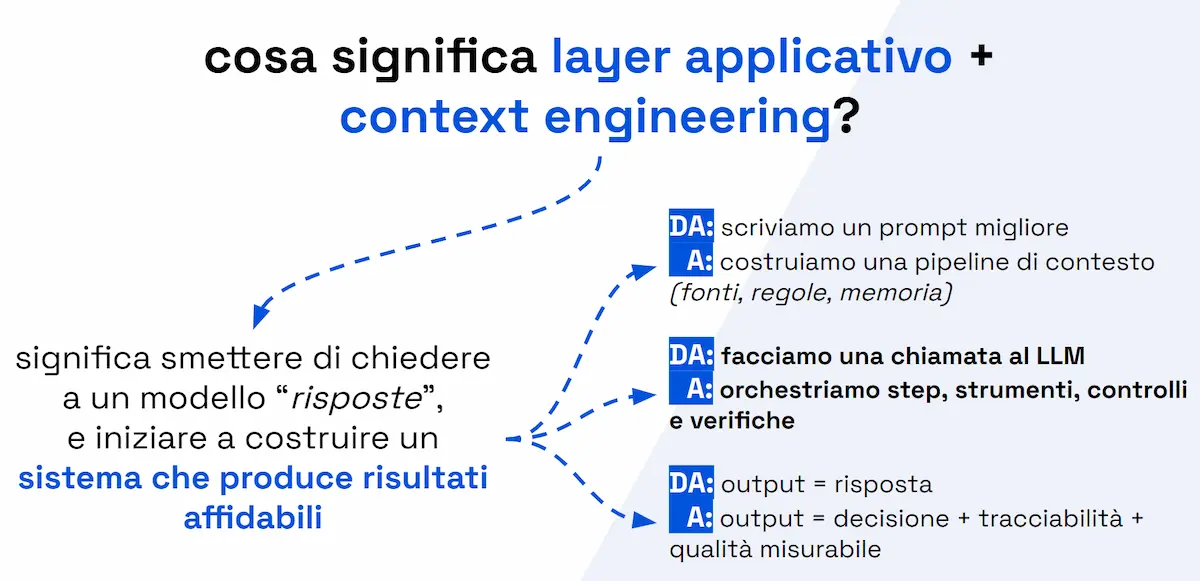

Per costruire applicazioni in produzione che non siano semplici "giocattoli", servono due pilastri fondamentali che vanno oltre il modello:

1. Il layer applicativo

Non basta il modello. Serve un'infrastruttura che gestisca:

- Input Shaping: come prepariamo i dati per l'AI.

- Context Pipeline: gestione delle fonti, RAG (Retrieval Augmented Generation) e policy aziendali.

- Tooling: la capacità dell'AI di usare CRM, Database, CMS e il web.

- Guardrails & Evals: regole di sicurezza e sistemi di valutazione automatica della qualità.

- Observability: monitoraggio dei costi e debug degli errori.

Senza questo layer, stiamo costruendo una demo, non un software.

2. Context Engineering

Dimentichiamo il Prompt Engineering. Il Context Engineering è l'evoluzione necessaria per i sistemi complessi. Non si tratta di scrivere una "buona frase per l'AI", ma di architettare l'informazione:

- Quali fonti contano? (Autorevolezza vs Rumore)

- Quanto contesto serve? (Bilanciamento Costi/Qualità)

- Cosa deve persistere nella memoria a lungo termine?

- Cosa va verificato (Grounding)?

La via migliore per implementare tutto ciò oggi è l'approccio Multi-Agente. Invece di far eseguire task elaborati a un unico modello, creiamo un "team virtuale" con ruoli specializzati, ad esempio:

- Planner: decide la strategia;

- Researcher: cerca il contesto e le informazioni;

- Executor: usa gli strumenti per compiere azioni;

- Reviewer: verifica l'output.

Framework come l'Agent Builder di OpenAI (e molte alternative open-source) ci permettono di creare questi workflow, ottenendo qualità più elevata, costi inferiori e output decisamente più affidabili.

Un seminario dedicato agli AI Agents

Se vuoi approfondire lo sviluppo e l'integrazione di sistemi agentici, ti suggerisco un seminario della nostra Accademia che ho progettato e curato personalmente.

Un seminario dedicato agli AI Agents

Una giornata avanzata dedicata alla progettazione e implementazione di workflow multi-agente, al context engineering e all’integrazione dell’AI nei team di agenzia, tra leadership, architetture e produzione reale.

Tappa 4: Proof (l'AI nel mondo reale)

Tutto questo può sembrare teorico finché non lo si vede in azione. Come diceva sempre Andrew Ng..

“La parte più difficile nella costruzione di sistemi di intelligenza artificiale non è il modello. È distribuirli in modo affidabile nel mondo reale.”.

Ecco due esempi concreti di come abbiamo messo in produzione questi concetti.

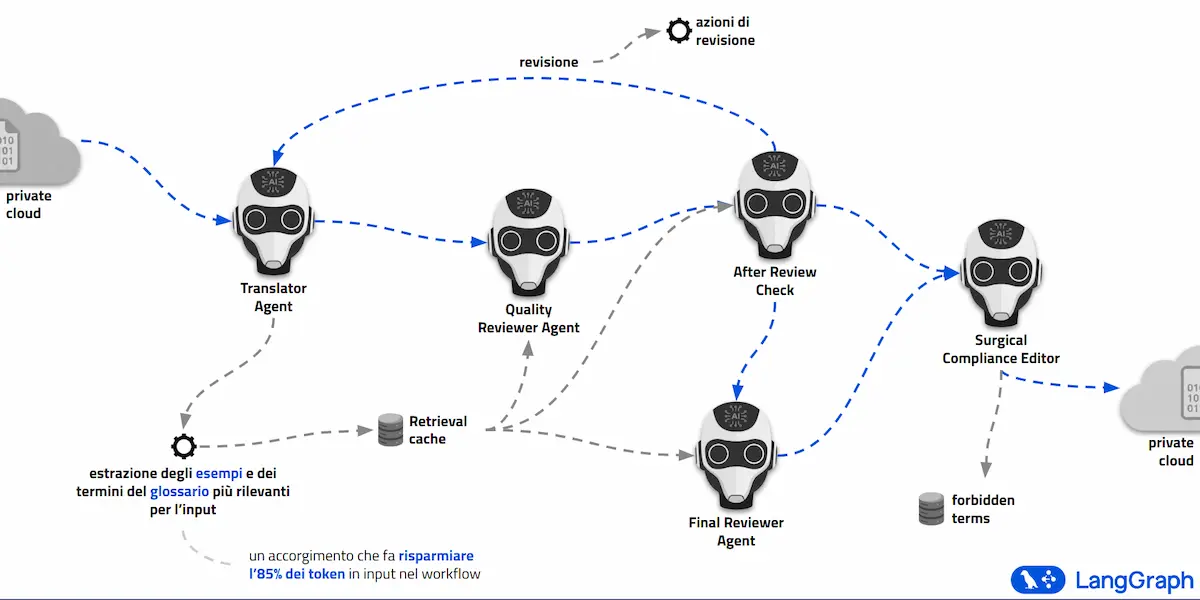

Caso studio 1: traduzioni di qualità

Abbiamo sviluppato un sistema che non si limita a "tradurre parole". Agisce come un team di traduttori madrelingua esperti del settore in cui opera il brand.

A differenza di un traduttore standard, questo sistema è addestrato per:

- Usare la terminologia specifica del settore verticale.

- Mantenere rigorosamente il tone of voice del brand.

- Rispettare un glossario specifico in base al contesto.

- Sostituire termini “vietati” specifici.

- Imparare dai propri errori, che non ripeterà.

Tecnologicamente, il sistema utilizza un'estrazione intelligente degli esempi (few-shot prompting dinamico) basata sulla rilevanza contestuale. Questo accorgimento permette di aumentare la precisione e di ridurre il consumo di token fino all'85%, rendendo il processo economicamente sostenibile su larga scala.

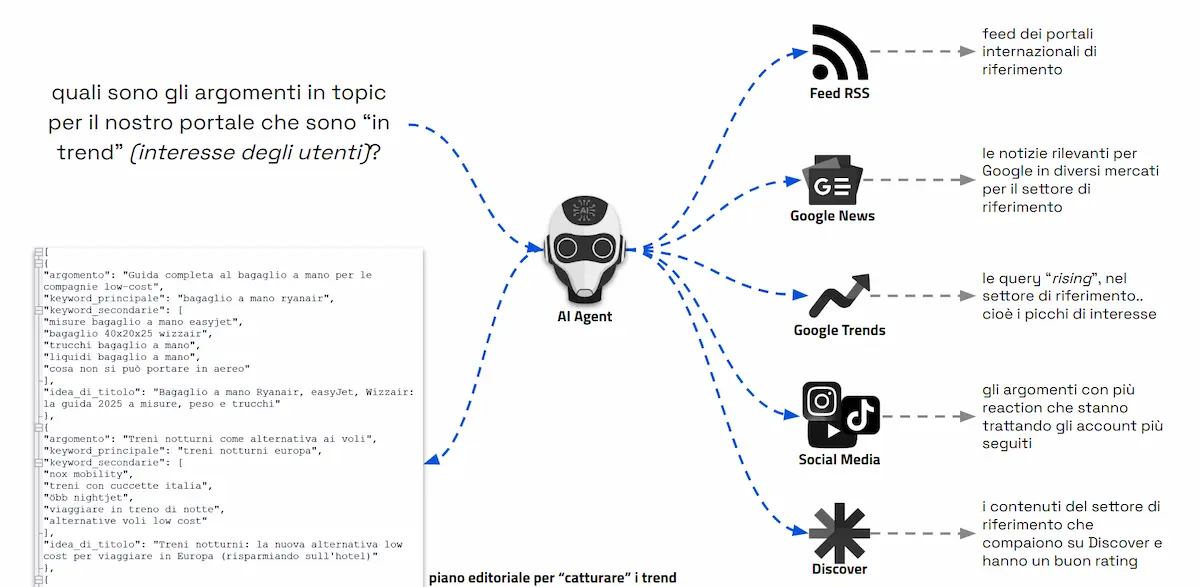

Caso studio 2: la redazione ibrida

Nel settore dell'editoria online, abbiamo reinventato il flusso di lavoro ponendo l'AI al centro del processo creativo e gestionale.

- CREA: il sistema sonda costantemente il web (RSS, Google Trends, Social Media, Google News) per individuare i trend emergenti. Propone piani editoriali mirati che l'editore umano approva (anche parzialmente). Una volta approvato, un sistema multi-agente scrive le bozze complete di alta qualità utilizzando anche tool esterni.

- AGGIORNA: l'AI monitora costantemente i dati di web analytics del sito. Se un contenuto non performa o è obsoleto, viene estratto, aggiornato con nuove informazioni e ottimizzato automaticamente.

- MASSIMIZZA: un agente verifica i prodotti in affiliazione citati nei contenuti. Se un prodotto non è più disponibile o non converte, lo sostituisce in modo armonico e contestuale.

In questo scenario, l'umano supervisiona, arricchisce con creatività e si concentra sulla qualità, mentre l'AI si fa carico del lavoro ripetitivo e dell'analisi dei dati in tempo reale.

Tappa 5: loop e world models (il futuro)

Guardando avanti, dobbiamo considerare l'esponenzialità del cambiamento. Siamo entrati in un loop virtuoso in cui l'AI viene usata per progettare l'infrastruttura per la prossima generazione di AI.

Progetti come AlphaEvolve di Google DeepMind mostrano già come l'AI stia ottimizzando il design dei chip e l'efficienza del codice, accelerando il proprio stesso sviluppo.

Ma la vera destinazione finale di questo viaggio si chiama World Models.

Yann LeCun ci ricorda che "la maggior parte della conoscenza umana non è linguaggio, è esperienza".

Fino ad oggi, abbiamo chiesto all'AI di descrivere il mondo prevedendo la parola successiva (token prediction). I modelli del futuro, e stiamo già vedendo i primi esempi come VL-JEPA di Meta, impareranno a rappresentare lo stato del mondo.

VL-JEPA di Meta

Stiamo passando da sistemi che descrivono il mondo attraverso il linguaggio a sistemi che lo "comprendono".

- Dai modelli che generano parole, a sistemi che simulano conseguenze.

- Dal linguaggio come centro del ragionamento, al linguaggio come "semplice" interfaccia di comunicazione.

Questi nuovi modelli non si limiteranno a rispondere a un prompt, ma capiranno contesti fisici, relazioni di causa-effetto e dinamiche temporali. Questo ci porterà a una qualità di automazione e pianificazione che oggi possiamo solo immaginare.

Meno rumore, più visione

Integrare l'Intelligenza Artificiale non significa adottare una nuova tecnologia. Significa abbracciare un nuovo modo di pensare il lavoro, l'innovazione e il nostro stesso ruolo professionale.

L'hype finanziario che vediamo oggi sui mercati è reale e forse è una bolla destinata a sgonfiarsi, ma l'impatto strutturale a lungo termine di questa tecnologia è ancora drasticamente sottostimato. La vera incognita non è se la tecnologia funzionerà, ma come la società e le aziende sapranno gestire l'urto di questo cambiamento.

Per questo, oggi più che mai, serve meno rumore e più visione. Perché questa non è una moda passeggera: è una trasformazione strutturale che stiamo appena iniziando a comprendere.

- GRAZIE -

Se hai apprezzato il contenuto, puoi

contribuire al progetto con una donazione 🙂