Le novità di OpenAI presentate al DevDay: alcune riflessioni

Non solo un elenco delle nuove funzionalità presentate da OpenAI (GPT-4 Turbo, 128k token, Whisper, TTS, Vision, DALLE-3, Code Interpreter, ecc.), ma qualche riflessione sul momento di straordinario cambiamento che stiamo vivendo.

Le novità presentate durante l'evento sono davvero tante. Tutte novità, però, che potremmo definire "orizzontali", che spaziano nelle dimensioni di velocità, prezzo e integrazione. Non si è parlato di nuove sostanziali capacità dal punto di vista cognitivo.

Questione di tempo in attesa di GPT-5

o il segnale di un plateau?

OpenAI DevDay

Una sintesi delle novità

Andiamo per gradi, riassumendo le nuove funzionalità presentate per punti chiave.

- Aumento della velocità e della finestra di contesto, con il nuovo modello GPT-4 Turbo che può gestire 128k token (impressionante!). Questo significa che, facendo una stima, potremo gestire documenti di oltre 300 pagine in un singolo prompt.

- GPT-4 Turbo avrà i dati di training aggiornati ad aprile 2023, e avrà la funzionalità di fine tuning, per creare modelli perfezionati. Anche ChatGPT godrà del nuovo knowledge cutoff.

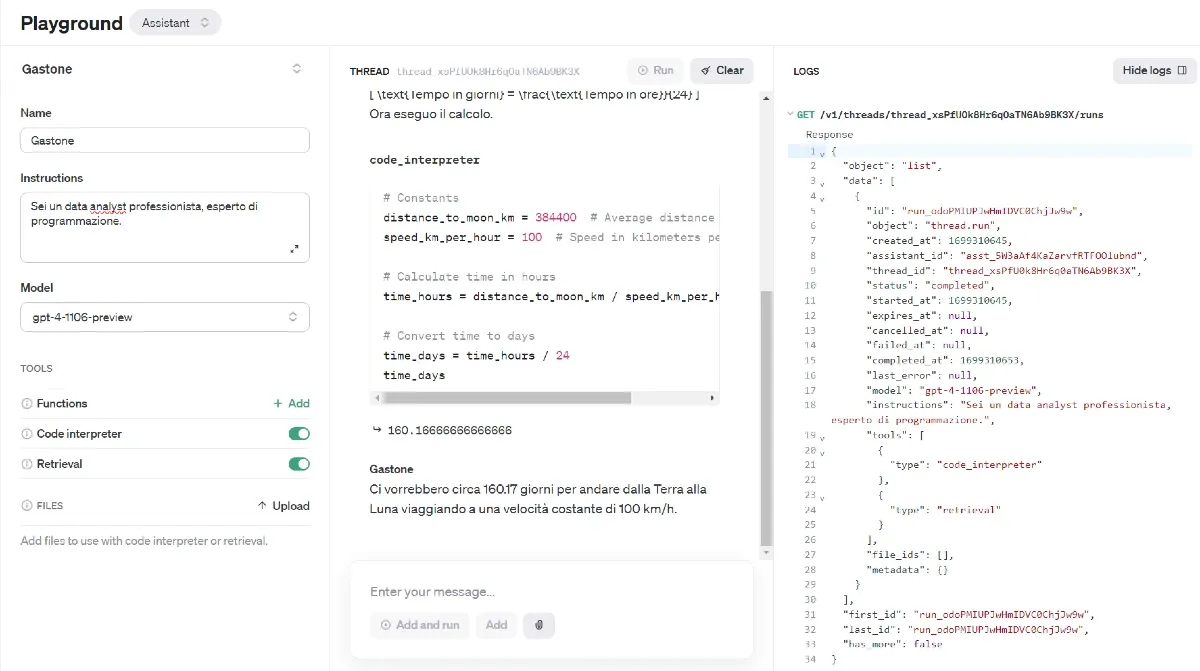

- API Assistants, per creare agenti specializzati in grado anche di utilizzare le funzioni, di usare Code Interpreter (quindi di sviluppare codice Python per rispondere alle richieste dell'utente) e di utilizzare una Knowledge Base personalizzata per l'addestramento. Nell'immagine che segue si può vedere un esempio di utilizzo.

- Vision e DALLE-3 disponibili via API. Questo significa che potremo elaborare e generare immagini all'interno delle nostre applicazioni in totale multimodalità (considerando anche TTS e ASR che vediamo a breve).

- Nuove API di sintesi vocale (TTS - Text To Speech) che permetteranno di generare voci di alta qualità.

- Riduzione dei costi: le API di GPT-4 Turbo avranno costi di 3 volte inferiori rispetto a GPT-4 per quanto riguarda i token di input, e di 2 volte inferiori per i token di output.

- Copyright Shield relativo all'utilizzo delle API e di ChatGPT Enterprise. OpenAI coprirà le spese legali dei clienti in caso di accusa di violazione del copyright.

- Whisper V3, il nuovo modello dedicato al riconoscimento vocale (ASR). Si potrà convertire l'audio in testo in modo più evoluto e veloce.

- Personalizzazione di ChatGPT, attraverso i "GPTs". Come ho detto fin dall'inizio, le istruzioni personalizzate erano praticamente inutili, perché troppo vincolanti per chi usa ChatGPT per diversi task. La nuova funzionalità permette di creare diversi agenti con caratteristiche personalizzate. Dei piccoli assistenti specializzati che rispondono alle nostre esigenze in modalità chat.

- I GPTs potranno essere connessi al "mondo reale" attraverso chiamate API, connessione a database e altre fonti di dati. Ad esempio si potranno creare GPTs personalizzati per assistere diverse figure in azienda.

- Per i clienti Enterprise, gli agenti potranno agire su dati aziendali garantendo un livello altissimo di personalizzazione e di gestione delle informazioni.

Dove possiamo approfondire in dettaglio tutte le novità?

La lista completa delle nuove funzionalità è disponibile attraverso le seguenti risorse pubblicate da OpenAI in occasione dell'evento.

Le novità per gli sviluppatori annunciate durante il DevDay di OpenAI

Le novità di ChatGPT annunciate durante il DevDay di OpenAI

Considerazioni

Plateau o no, OpenAI con questo evento ha dimostrato un vantaggio importante nello sviluppo rispetto a qualunque altro competitor, forte anche della partnership con Microsoft (Satya Nadella ha partecipato all'evento salendo sul palco per uno scambio con Sam Altman).

Credo che ieri sera abbiano annientato (o quasi) qualunque stimolo di ricerca di alternative, da parte di professionisti e aziende.

Siamo onesti.. fino a ieri, si pensava a Claude 2 di Anthropic solo se la finestra di contesto di GPT-4 non era sufficiente per l'elaborazione necessaria. E anche se domani Anthropic annunciasse delle novità, credo che il gap sia comunque consistente, non solo in termini di funzionalità, ma anche di performance.

Oppure fino a ieri si pensava a PaLM 2 e a Vertex AI di Google? Non credo.

E anche la politica che fa leva sulla sicurezza inizia a vacillare se consideriamo le soluzioni Enterprise di OpenAI (che cresceranno e si evolveranno!). Recentemente Google ha fatto un tentativo di "farsi sentire" annunciando il supporto legale per violazioni di copyright derivanti dall'uso dei loro modelli generativi.. ma anche questo, dopo ieri sera, non rappresenta più un vantaggio.

Google, in generale, sembra non riuscire a rimanere al passo in questo ambito. In occasione di ogni evento presentano novità, seguite da azioni scoordinate e poco convincenti (Bard, SGE, Duet AI, Assistant, Gemini.. dov'è finito?). Insomma, in casa Google, si concretizza poco.

Credo siano davvero tempi duri per Google, ed è la prima volta in 20 anni che lo penso.

Ma andiamo avanti.. Cosa rimane? Llama 2 di Meta? Un'altra soluzione estremamente evoluta, ma dalle performance inferiori e con un parco integrazioni completamente da costruire.

Concludo le mie considerazioni con un'ultima nota, da leggere dopo aver visto questo video che mostra i GPTs in azione.

You can now create custom versions of ChatGPT that combine instructions, extra knowledge, and any combination of skills.

Siamo tutti d'accordo che il concetto di "Prompt Design" merita una rivalutazione?

Per approfondire

We're rolling out new features and improvements that developers have been asking for:

— OpenAI (@OpenAI) November 6, 2023

1. Our new model GPT-4 Turbo supports 128K context and has fresher knowledge than GPT-4. Its input and output tokens are respectively 3× and 2× less expensive than GPT-4. It’s available now to…