AI Generativa Multimodale: uno step oltre il concetto di Text-to-Image

Grazie a un'esplorazione di Meta AI sull'intelligenza artificiale e agli algoritmi generativi, possiamo proiettarci verso il concetto di AI Generativa Multimodale. Si tratta di un nuovo approccio che consente di generare immagini di qualità partendo da uno "schizzo" ed una descrizione testuale.

L'uso dell'intelligenza artificiale (AI) per aumentare la creatività umana è un potente uso della tecnologia, che si tratti di generare avatar espressivi, animare i disegni dei bambini, creare nuovi mondi virtuali nel metaverso, o produrre splendide opere d'arte digitali utilizzando delle semplici descrizioni di testo.

Tuttavia, probabilmente, non è sufficiente che un sistema di AI generi solo contenuti. Per realizzare il potenziale degli algoritmi nel portare avanti l'espressione creativa, le persone dovrebbero essere in grado di modellare e controllare il contenuto generato. Dovrebbe essere intuitivo e facile da usare in modo da sfruttare qualsiasi modalità espressiva, che si tratti di parlato, testo, gesti, movimenti oculari o persino "schizzi", per dare vita alle visioni umane con qualsiasi mezzo sia funzionale, incluso audio, immagini, animazioni, video e 3D.

Immagina di creare bellissimi dipinti impressionisti senza saper prendere in mano un pennello. O di generare all'istante illustrazioni che accompagnano le parole di un libro.

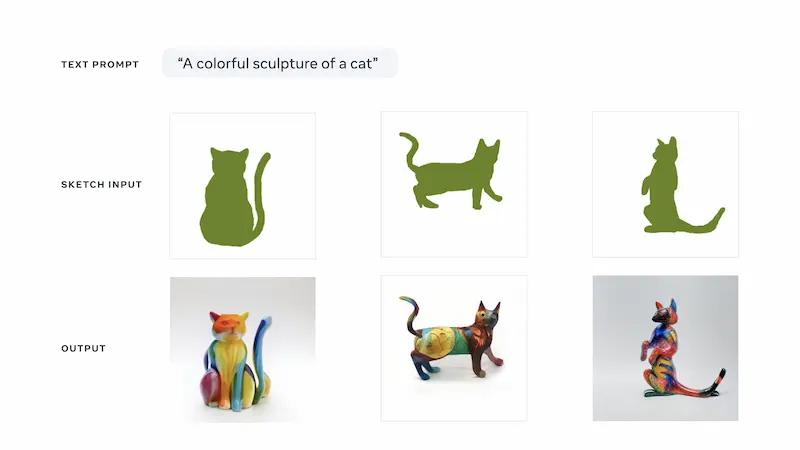

Meta AI ha recentemente presentato una ricerca esplorativa sull'intelligenza artificiale denominata Make-A-Scene: un sistema per consentire a chiunque di dare vita alla propria immaginazione. Possiamo parlare di AI generativa multimodale, che mette il "controllo creativo" nelle mani delle persone, consentendo loro di descrivere l'immaginazione attraverso delle semplici illustrazioni realizzate a mano libera e descrizioni di testo.

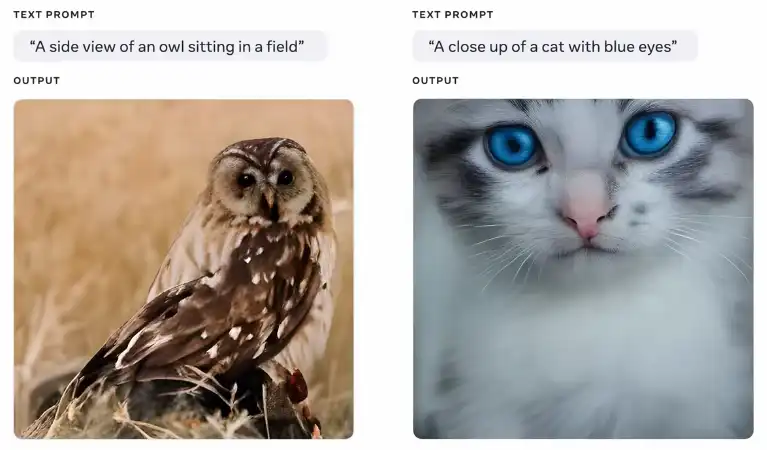

I sistemi di intelligenza artificiale ai quali oggi siamo abituati generano immagini di qualità utilizzando principalmente una descrizione di testo come input. Nel seguente post descrivo i più noti algoritmi che appartengono a questa tipologia.

Ma i messaggi di testo, come "un dipinto con una zebra in sella a una bicicletta", generano immagini attraverso composizioni che possono essere difficili da prevedere. La zebra potrebbe trovarsi sul lato sinistro dell'immagine o sulla destra, ad esempio, oppure potrebbe essere molto più grande della bicicletta o molto più piccola; oppure la zebra e la bicicletta potrebbero essere di fronte alla telecamera oppure di profilo. Di conseguenza..

L'immagine potrebbe non essere un riflesso della voce creativa di una persona.

Se, ad esempio, si desidera specificare la dimensione della ruota della bicicletta, l'orientamento del manubrio e la larghezza della strada, non esiste un modo semplice per trasmettere tutti questi elementi utilizzando solo una descrizione testuale.

Con Make-A-Scene le persone possono utilizzare sia testo che semplici disegni per trasmettere la propria visione con maggiore specificità, usando una grande varietà di elementi, forme, disposizioni, profondità, composizioni e strutture.

Un test con utenti reali

Per comprendere l'efficacia dell'algoritmo sono stati realizzati dei test su "valutatori" umani. A ciascuno sono state mostrate due immagini prodotte da Make-A-Scene: una generata solo da un prompt di testo, e un'altra dalla combinazione di "schizzo" e testo. Per lo schizzo è stata utilizzata una mappa di segmentazione di un'immagine estratta da un set di dati pubblico, e in entrambe le generazioni, per l'input di testo è stata utilizzata la didascalia dell'immagine.

I risultati del test dimostrano che l'immagine generata da testo e "schizzo" è stata ritenuta quasi sempre (il 99,54% delle volte) più a allineata con lo schizzo originale. Spesso (il 66,3% delle volte) è stata valutata anche come più allineata con il prompt di testo.

Ciò dimostra che le generazioni di Make-A-Scene sono davvero fedeli alla visione di una persona comunicata attraverso lo schizzo.

L'addestramento

Come altri modelli di intelligenza artificiale generativa, Make-A-Scene è stato addestrato sulla relazione tra elementi visivi e testuali attraverso milioni di immagini di esempio.

Il settore dell'IA è ancora agli inizi per comprendere e affrontare queste sfide e c'è ancora molto lavoro da fare.

Secondo Meta AI, la "trasparenza" dei modelli accelererà i progressi in tal senso. Come passo verso la promozione della trasparenza, per addestrare Make-A-Scene è stato utilizzato un set di dati pubblico, in modo da aiutare la community che ruota intorno all'Intelligenza Artificiale, di analizzare, studiare e comprendere il sistema.

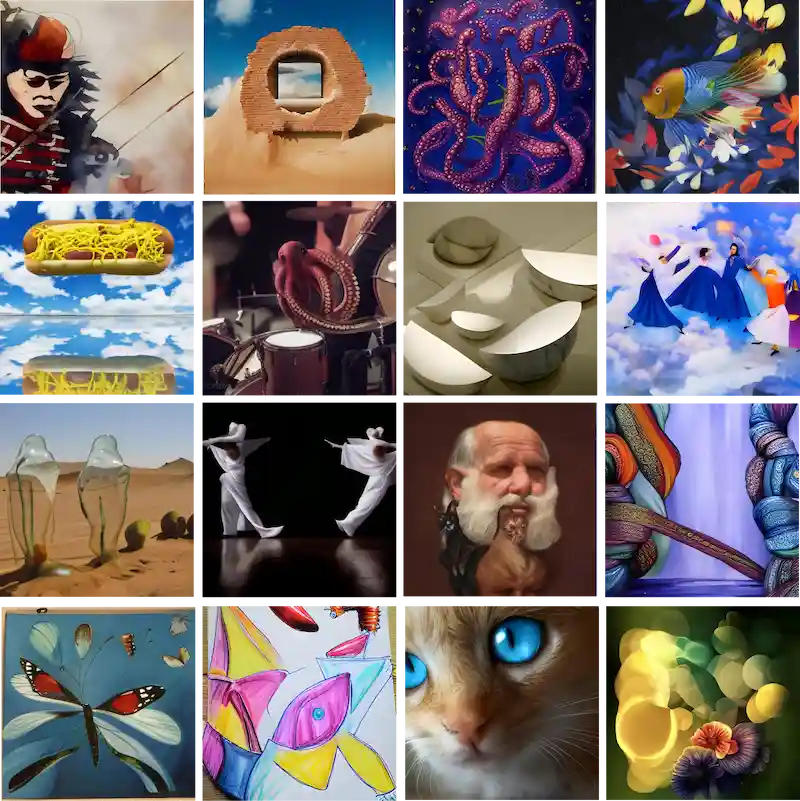

Make-A-Scene può anche generare il proprio layout di scena con prompt di solo testo, come vediamo nell'immagine. Il modello si concentra sull'apprendimento di aspetti chiave delle immagini che hanno maggiori probabilità di essere importanti per il creator, come oggetti o animali. Questa tecnica ha contribuito ad aumentare la qualità della generazione, come valutato dal punteggio FID ampiamente utilizzato, che valuta la qualità delle immagini create dai modelli generativi.

Il potenziamento della creatività per artisti e non

Quindi, le persone come userebbero Make-A-Scene per dare vita alla loro immaginazione? Nel percorso di ricerca e sviluppo del sistema, è stato condiviso l'utilizzo di Make-A-Scene con noti artisti che conoscono queste modalità di utilizzo dell'AI, tra cui Sofia Crespo, Scott Eaton, Alexander Reben e Refik Anadol, con l'obiettivo di ottenere un feedback.

Quelle che seguono sono alcune valutazioni degli artisti.

La prossima generazione di strumenti di intelligenza artificiale creativi

Attraverso la ricerca scientifica e progetti esplorativi come Make-A-Scene, è possibile espandere i confini dell'espressione creativa, indipendentemente dalle capacità artistiche. L'obiettivo è quello di rendere facile per le persone dare vita alla loro visione nel mondo fisico e nel metaverso.

Questo sforzo di ricerca fa parte dell'impegno di Meta nell'esplorazione dei modi in cui l'IA può potenziare la creatività, che si tratti di dare vita a degli schizzi 2D, utilizzare il linguaggio naturale tra le altre modalità per creare oggetti 3D, costruire interi spazi virtuali, o qualsiasi altro progetto creativo.

Un giorno potrebbe consentire forme completamente nuove di espressione basata sull'intelligenza artificiale, mettendo i creatori e la loro visione al centro del processo, che si tratti di un direttore artistico che sta ideando la loro prossima campagna creativa, un influencer dei social media che crea contenuti più personalizzati, un autore che sviluppa illustrazioni uniche per i propri libri e storie, o semplicemente qualcuno che condivide un augurio divertente e unico per il compleanno di un amico.

Si stanno facendo progressi in questa direzione, ma è solo l'inizio. Gli strumenti generativi diventeranno sempre più potenti per costruire messaggi più ricchi ed espressivi.

Per approfondire