GPT-3 per la SEO: potenzialità, limiti, futuro. Il mio WMF 2022

Quest'anno al WMF, in sala SEO, ho parlato di GPT-3 e di generazione di contenuti attraverso l'intelligenza artificiale. Come funziona? Cosa rappresenta? Qual è il futuro del lavoro aumentati dagli algoritmi? Capire la natura del mezzo, genera il vero vantaggio competitivo.

Dal 16 al 18 giugno nella Fiera di Rimini, si è svolto il WMF (Web Marketing Festival, ma anche We Make Future), il più grande festival sull'innovazione digitale.

Anche quest'anno ho avuto il piacere di tornare sul palco, in sala SEO, per condividere informazioni ed esperienze fatte con la generazione di testi (e non solo) attraverso l'intelligenza artificiale.

Questo speech nascondeva una sfida: raccontare un argomento molto tecnico rendendolo interessante per tutti. Spero di esserci riuscito.

Nel paragrafo che segue, ripercorro l'intervento sintetizzandone i concetti.

GPT-3 e Text Generation (..ma non solo): le potenzialità, i limiti, il futuro

Prima di tutto, ho chiesto all’algoritmo di creare uno slogan per questo titolo. GPT-3 ha prodotto il seguente testo..

GPT-3 è il futuro della generazione di testi, con il potenziale per rivoluzionare il modo in cui comunichiamo.

Abbastanza ambizioso come algoritmo, direi :)

Quindi, andiamo a scoprire se ha ragione!

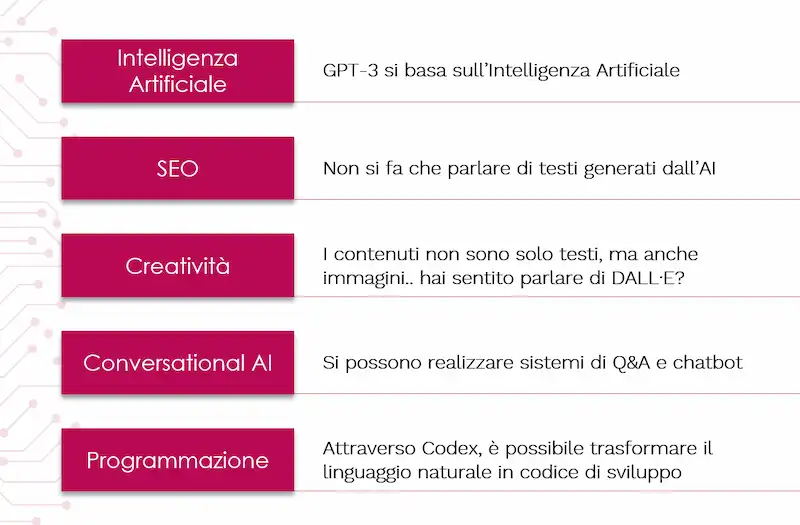

A quali ambiti associamo GPT-3?

- Intelligenza artificiale: l'associazione più naturale, perché si tratta di un sistema basato sull’AI.

- SEO: ormai non si fa che parlare di testi generati dall’AI, e di test SEO che coinvolgono questa tipologia di contenuti.

- Creatività: non si tratta solo di testi.. ad esempio, attraverso DALL·E, un "derivato" di GPT-3, partendo da una richiesta in linguaggio naturale è possibile ottenere delle immagini.

- Conversational AI: questa tecnologia consente di creare sistemi di Q&A e chatbot. A questo proposito, consiglio il seguente post, in cui condivido i primi dialoghi in italiano con GPT-3.

- Programmazione: grazie a Codex, un altro "derivato" di GPT-3, possiamo trasformare il linguaggio naturale in codice.

Cos'è GPT-3?

GPT-3 è un modello di linguaggio che utilizza il deep learning per generare testo (e non solo) simile a quello che produrrebbe un essere umano.

Si tratta di un algoritmo creato da OpenAI, e l’acronimo sta per Generative Pre-trained Transformer, di terza generazione. Quindi è un sistema generativo, pre-addestrato, e basato sui "Transformer".

I "numeri" di GPT-3

Lo storytelling che ruota intorno a questi modelli porta con sé dei "numeroni" che spesso vengono utilizzati per stupire.. ma cosa rappresentano? Andiamo a scoprirlo.

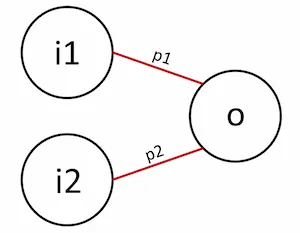

1) 175 miliardi di parametri. GPT-3, è un algoritmo basato su una "rete neurale artificiale".. ma non dobbiamo farci spaventare dai termini: dal punto di vista matematico non è altro che una funzione che trasforma degli input in output (relaziona ingressi e uscite).

- I parametri, o pesi, a livello grafico, sono rappresentati dalle connessioni tra gli input e gli output (p1 e p2 nello schema che segue); a livello matematico, invece, sono i valori che, combinati con gli input generano gli output della rete.

- La fase di training dell’algoritmo, va proprio a valorizzare quei pesi per far sì che l’output sia secondo le aspettative.

- Più il numero di parametri è elevato, più l’algoritmo sarà preciso, ma anche oneroso in fase di training.

2) 45 TB di dati per l'addestramento. Cosa significa? Ma soprattutto, quali sono questi dati?

- Wikipedia (3,5%). Un set perfetto per la modellazione linguistica.

- WebText (18,9%). Pagine web estratte da link uscenti da post di Reddit votati positivamente dagli utenti (+45M pagine web).

- Books1 (7,8%) e Books2 (8,1%). Libri disponibili online, in inglese (1) e altre lingue (2).

- Common Crawl (61,7%). Un archivio di dati ricavati da pagine web (la maggior parte in lingua inglese).

Dopo queste considerazioni, possiamo iniziare a comprendere la natura di GPT-3.

GPT-3 è un algoritmo ad elevate prestazioni, che offre il meglio di sé sui contenuti brevi e generici, e che il suo addestramento deriva principalmente

da pagine web in lingua inglese.

Cosa significa "Transformer"?

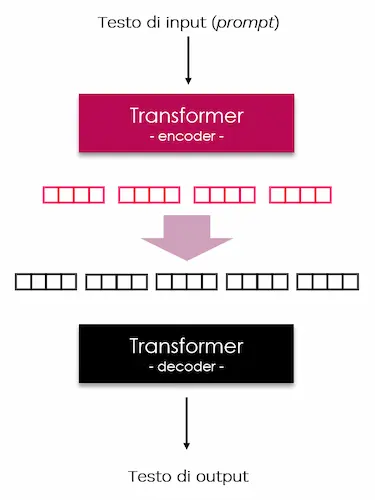

Come dicevamo inizialmente, GPT-3 è un sistema che si basa sui Transformer.. cosa significa?

Si tratta dell'architettura del modello, ovvero un sistema che riceve un input di testo, un prompt, e lo codifica in un set di dati. Dati che vengono trasformati dall’algoritmo (in base alla tipologia e all'addestramento) e decodificati in testo d'uscita.

Uno degli elementi rivoluzionari dei transformer è la capacità di elaborare l’intero input.. Questo migliora la capacità di parallelizzazione del training, rendendolo più efficiente. Tale architettura, oggi, è alla base di qualunque task che riguarda il linguaggio naturale (es. topic modeling, sentiment analysis, classification) e di tutti i moderni modelli di linguaggio (es. BERT, T5, Gopher).

Questi algoritmi non sono altro che dei calcolatori di probabilità.. attraverso un approccio probabilistico, prevedono il completamento del testo.

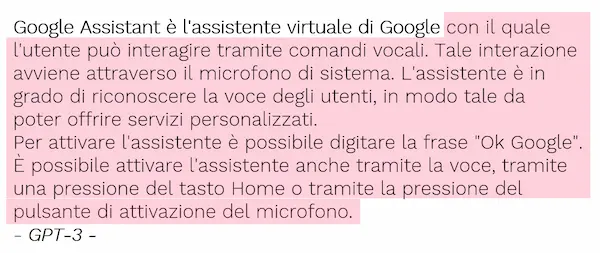

E lo fanno molto bene! Nell'immagine che segue, vediamo come da un input composto da qualche parola viene prodotto un testo sensato e ben scritto su Google Assistant.

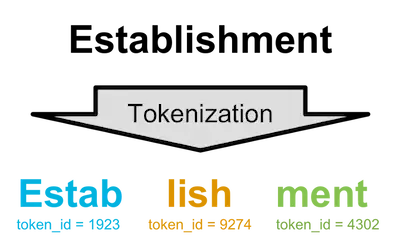

GPT-3, inoltre, non genera dei completamenti considerando parole.. in realtà non sa nemmeno cosa siano le parole, ma considerando dei token, cioè delle sequenze di caratteri.

Tutto questo per giungere a quale conclusione?

GPT-3 è un "bullshit artist", che non impara nulla sul mondo, ma solo su come le persone usano le parole.

- Gery Marcus -

Quindi non c’è comprensione, e non c’è intelligenza come le intendiamo noi, ma soltanto freddo calcolo statistico.

Come si integra GPT-3 nei flussi di creazione di contenuti

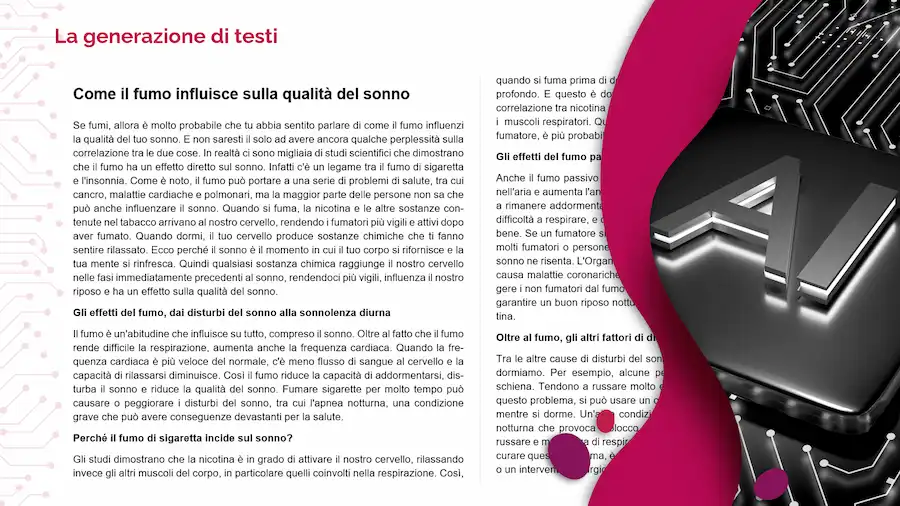

Tutte le considerazioni fatte fino a questo punto, ci portano forse a pensare che sarebbe meglio non utilizzare questi sistemi professionalmente? Assolutamente no! Quello che segue, infatti, è un esempio di post di blog generato usando GPT-3.

Ma come si integrano questi sistemi in un flusso di lavoro?

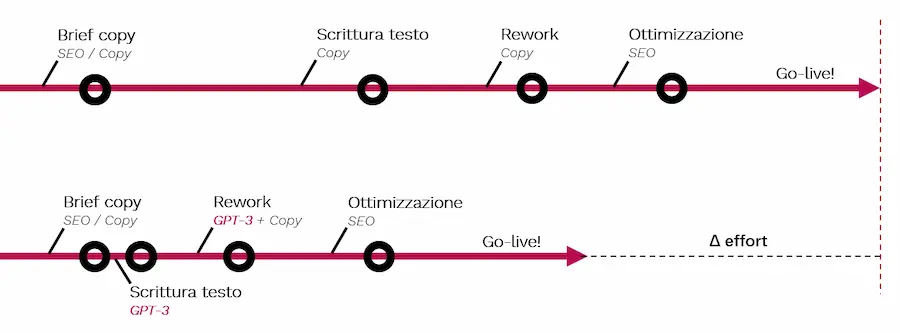

Quello che vediamo nella parte alta dell'immagine è uno schema semplificato di azioni per la produzione di contenuti, ad esempio per una strategia SEO. Quindi si susseguono il brief copy, l’analisi e la scrittura del testo, l’eventuale re-work, l’ottimizzazione da parte del team SEO, ed infine il go-live.

Come cambia il flusso con l’ingresso nel team di GPT-3 o di algoritmi di questo tipo? Lo vediamo nella parte più bassa della stessa immagine. Come si nota, le fasi sono le stesse, ma alcune (scrittura e re-work) risultano essere più "compresse".

La differenza di effort può rappresentare un risparmio di tempo, di denaro, oppure "forza" da reinvestire nel miglioramento della qualità dell'output.

Alcune note per l'integrazione

- Per prima cosa, valutiamo se l’algoritmo è la soluzione migliore in termini di tipologia di contenuto, argomento e lingua (anche in combinazione tra di loro).

- Utilizziamo GPT-3 via API con parametri e strutture di prompt collaudati nel tempo. I parametri sono i valori che vengono inviati via API a corredo del prompt per settare la modalità con la quale l'algoritmo va a completare i contenuti. Il prompt, invece, è il "brief copy" che inviamo all'algoritmo per descrivere le operazioni da compiere, gli esempi, lo stile, ecc..

- Scomponiamo la generazione di un testo in diversi testi più brevi, perché GPT-3 è più performante nella scrittura di testi brevi.

- Usiamo il fine-tune training per migliorare l’output.

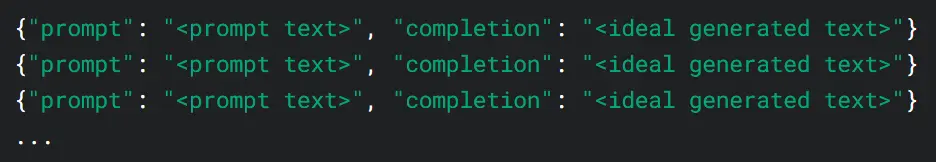

Cos'è il fine-tune training?

si tratta di una modalità di addestramento messa a disposizione da GPT-3 che permette di passare al modello dei dati di training aggiuntivi, per trasmettere un determinato tone of voice e per aumentare la base di conoscenza del sistema.

Come vediamo dallo schema, diamo al sistema esempi aggiuntivi, rendendolo un modello perfezionato, per migliorare l’output e ridurre gli errori.

Il seguente post approfondisce in dettaglio la fase di fine-tune training.

Considerando l’effort derivante dall'addestramento aggiuntivo, ha molto più senso usare GPT-3 per un piano editoriale, rispetto alla creazione di singoli contenuti.

Le funzionalità di INSERT ed EDIT di GPT-3

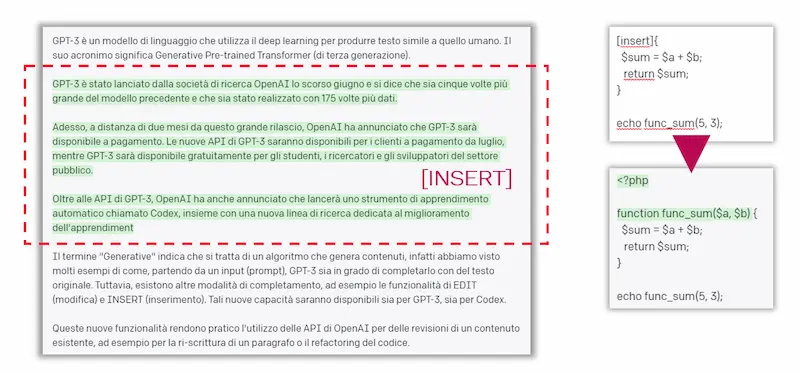

Prima abbiamo visto che GPT-3 può essere usato anche in fase di re-work dei contenuti. In che modo? Ad esempio grazie alla modalità di “insert”, che permette di aggiungere del testo ad un contenuto mantenendone il contesto.

Per utilizzare la modalità, è sufficiente inserire un placeholder (“[insert]”) all'interno di un testo, e l’algoritmo va a sostituirlo con il completamento.

Nello schema vediamo un esempio di insert in un testo ed anche in una semplice funzione PHP.

Un’altra nuova funzionalità di GPT-3 è quella di "edit", attraverso la quale possiamo dare un brief di modifica di un testo all’algoritmo. In un test, ho utilizzato la definizione di GPT-3 come testo di input:

GPT-3 è un modello di linguaggio che utilizza il deep learning per produrre testo simile a quello umano. Il suo acronimo significa Generative Pre-trained Transformer (di terza generazione).

Come istruzioni di modifica ho chiesto: "riscrivilo come fosse GPT-3 a parlare". Il seguente è l'output che ho ottenuto:

Ciao, sono un modello di linguaggio che utilizza il deep learning per produrre testo simile a quello umano. Il mio acronimo significa Generative Pre-trained Transformer (di terza generazione).

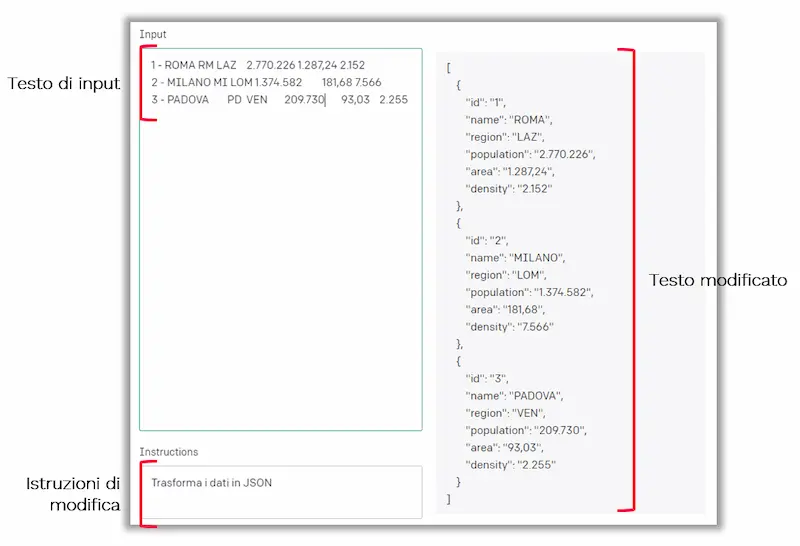

In un altro esempio, ho utilizzato 3 righe di dati demografici copiati da un sito web e ho chiesto all'algoritmo di trasformare i dati in JSON.

In output otteniamo il dato strutturato in formato JSON. Da notare che l'algoritmo ha anche etichettato i dati.

Il post che segue, descrive in maniera dettagliata le funzionalità di INSERT ed EDIT di GPT-3.

I testi dei prodotti dell'e-commerce

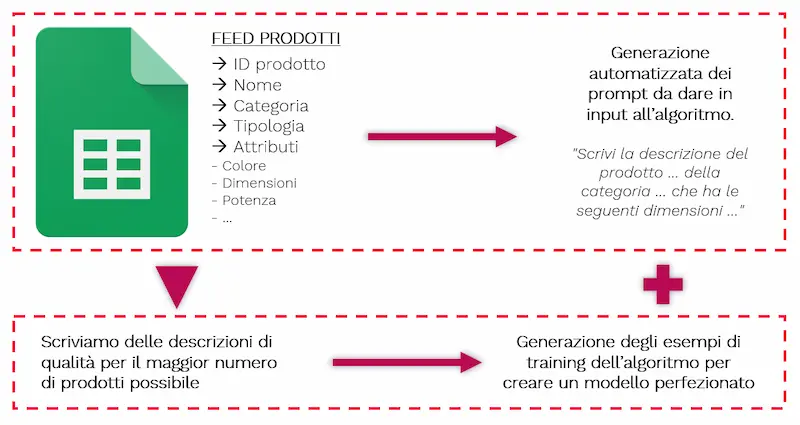

Un’altra applicazione interessante riguarda la scrittura dei testi per siti web di e-commerce. Immaginiamo di avere migliaia di prodotti con le schede senza descrizione e di voler colmare il "content gap" rispetto ai competitor. In questo caso, o li scriviamo tutti, o, di solito, scendiamo a compromessi della serie “scriviamo le schede prodotto più importanti”. Oppure, oggi, possiamo provare ad usare un algoritmo.

Come si procede? Possiamo partire dal feed dei dati dei prodotti. Con un semplice script generiamo dei prompt automatizzati per GPT-3, ad esempio: “Scrivi la descrizione del prodotto X della categoria Y, che ha le seguenti dimensioni, ecc..". Basterebbe passare questi prompt a GPT-3 per ottenere dei testi della lunghezza che desideriamo (chiaramente dipende dalla tipologia dei prodotti e da altri fattori).

Tuttavia, per puntare a testi di maggior qualità, possiamo attuare una ulteriore strategia. Possiamo usare un centinaio dei prompt ed usarli come brief per dei copy professionisti, ottenendo un centinaio di testi di qualità.

A questo punto, usando prompt e testi possiamo effettuare un fine-tune training per ottenere il modello perfezionato relativo al progetto.

Infine, non resta che inviare a GPT-3 tutti i prompt generati automaticamente partendo dal feed, usando il modello perfezionato, per ottenere contenuti di qualità.

Tutto questo per arrivare ad un'importante conclusione: GPT-3 è un motore performante, ma nelle competizioni che contano un buon motore non basta. Training e costruzione del prompt sono determinanti per far performare questi sistemi.

Google e i testi generati automaticamente

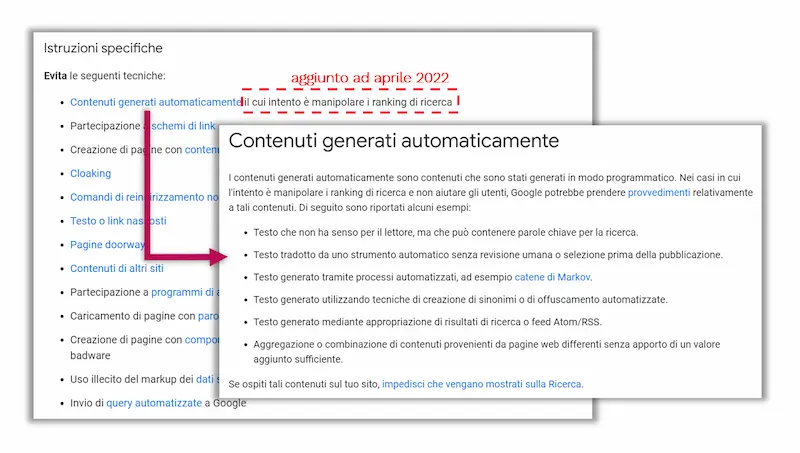

Qual è la posizione di Google su questa tipologia di testi? Recentemente sono stati pubblicati dei post di puro "terrorismo" riferiti alle linee guida in cui Big G afferma di evitare di generare contenuti automaticamente, e ad aprile ha aggiunto.. “il cui intento è manipolare il ranking”.

Ma attenzione.. noi non stiamo usando pattern per creare contenuti automatici per "manipolare il ranking"; stiamo integrando un algoritmo che ci aiuta nel nostro workflow per ridurre l’effort ed aumentare la qualità delle pagine. Quindi cerchiamo di usare il buonsenso quando interpretiamo le linee guida.

La classificazione

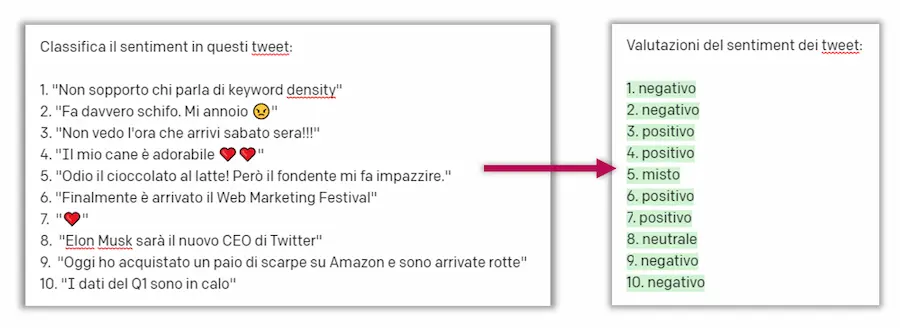

Come possiamo classificare dei testi come tweet, messaggi o recensioni dell'e-commerce attraverso GPT-3? Quello che segue è un esempio in cui è possibile vedere il prompt e anche l'output.

Usando, successivamente, anche i parametri logit_bias e temperature, è possibile rendere gli output molto più fedeli.

Limitazioni e problematiche

Nel percorso abbiamo già incontrato diverse limitazioni relative a GPT-3 ed in generale ai LLM (Large Language Model) e a queste grandi reti neurali. Ma vorrei concludere con altre due.

- L’impatto ambientale. Quanta energia è necessaria per addestrare una rete come GPT-3? Diciamo che la produzione di CO2 stimata, sarebbe comparabile a quella prodotta da un’auto che percorre 700.000 km. Per non parlare del costo (diversi milioni di dollari).

Con la tecnologia attuale, più i modelli diventeranno ampi, è più l'impatto ambientale sarà importante.

Teaching the neural super-network in a Microsoft data center using Nvidia GPUs required roughly 190,000 kWh, which using the average carbon intensity of America would have produced 85,000 kg of CO2 equivalents, the same amount produced by a new car in Europe driving 700,000 km, or 435,000 miles, which is about twice the distance between Earth and the Moon, some 480,000 miles.

- Carbontracker - University of Copenhagen -

- La generazione di testi tossici. In precedenza, abbiamo visto quali sono i dati con i quali è stato addestrato GPT-3. L'algoritmo, oltre ad apprendere informazioni, acquisisce i BIAS cognitivi che ne derivano. Quindi possono nascere testi che contengono espressioni razziste o sessiste, ed in generale disinformazione. OpenAI ha creato dei modelli definiti InstructGPT che migliorano moltissimo l’algoritmo, ma serve attenzione.

Se usiamo l'intelligenza artificiale per generare testi, successivamente dobbiamo usare la nostra intelligenza NON artificiale per utilizzarli.

Quale sarà il futuro di questi modelli?

Partiamo da una citazione di Elon Musk, che dice..

The rate of improvement from original GPT to GPT-3 is impressive. If this rate of improvement continues, GPT-5 or 6 could be indistinguishable from the smartest humans.

..e probabilmente ha ragione! Ma non dimentichiamoci che non esiste solo GPT-3, e non esiste solo OpenAI.

Google, infatti, ha appena rilasciato PaLM (Pathways Language Model), un modello con 540 miliardi di parametri (3 volte più grande di GPT-3), che usa una nuova tecnica per rendere più efficiente l'addestramento (Pathways) e che nei test ha superato la media delle persone alle quali è stato chiesto di effettuare gli stessi compiti.

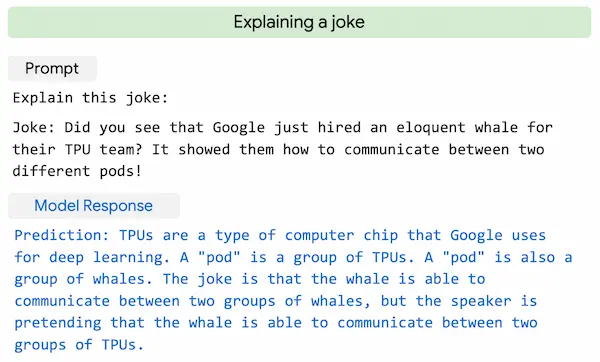

Di seguito vediamo un esempio in cui l’algoritmo spiega una barzelletta.. e questo sembra davvero incredibile.

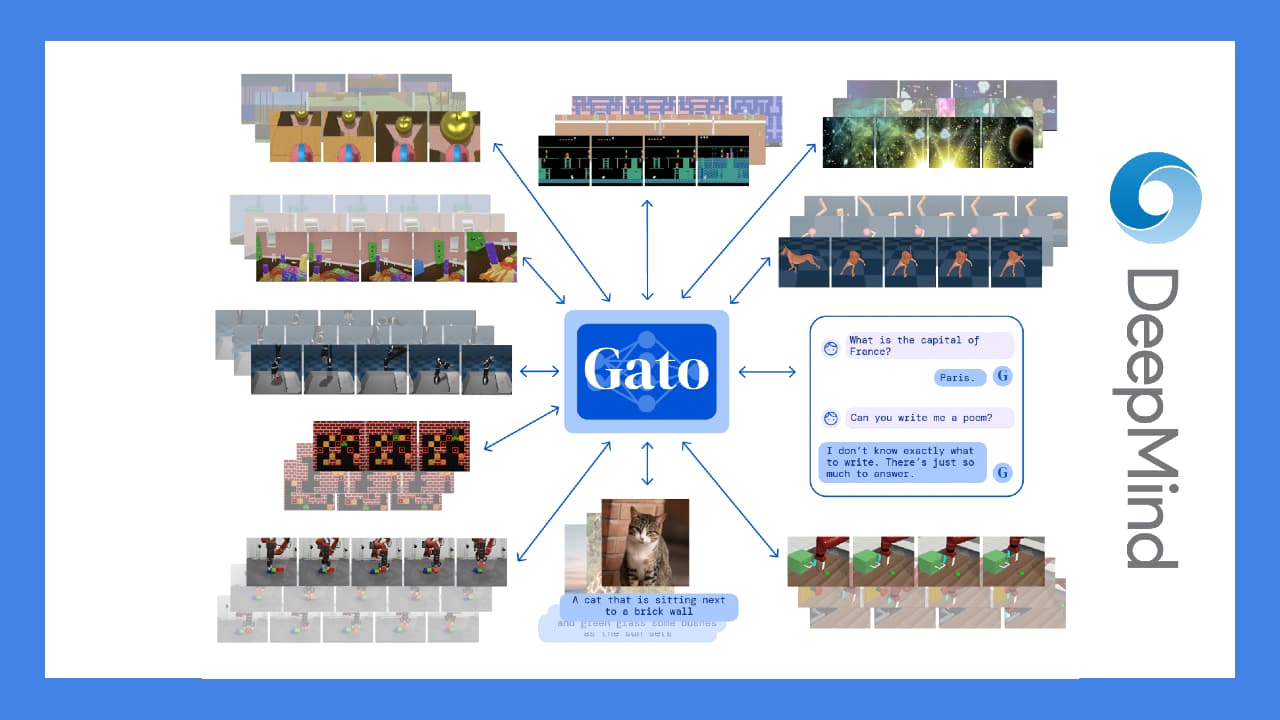

DeepMind ha recentemente presentato Gato, un nuovo modello multimodale e multi tasking: lo stesso algoritmo può compiere oltre 600 task diversi. Quindi non aumentano soltanto i parametri nell'evoluzione di questi sistemi, ma migliorano anche le tecniche di addestramento. Quello che segue, è un approfondimento su Gato.

Google, inoltre, a proposito di generazione di immagini da testo, ha lanciato Imagen, il più potente algoritmo esistente che ha distrutto tutti gli altri algoritmi per pertinenza e qualità.

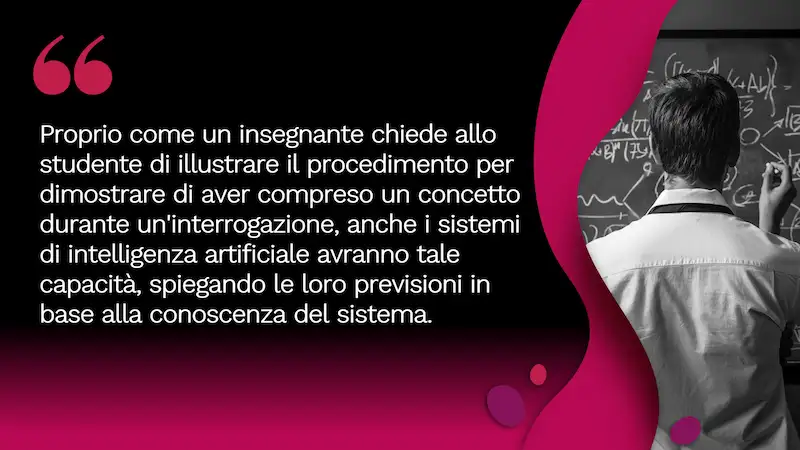

La prossima generazione di algoritmi andrà a valorizzare la fiducia tra l'utente e l'IA nelle applicazioni del mondo reale.

Si sta ragionando, infatti, su come aumentare la fiducia delle persone sugli algoritmi per trasformare l'intelligenza artificiale da una black box ad un libro aperto. E la risposta sembra arrivare dai grafi della conoscenza.. proprio i knowledge graph, come quello che usa Google per correlare le informazioni nel web.

I knowledge graph potranno trasformare l’AI in qualcosa di comprensibile e controllabile, perché potranno affiancare le loro previsioni ad un contatto con il mondo reale.

Quindi come uno studente spiega all’insegnante il procedimento che l'ha portato al risultato, gli algoritmi del futuro ci spiegheranno come sono arrivati a dare la loro previsione.

Conclusioni

Dove siamo diretti? Siamo diretti verso..

- un’AI che diventerà sempre più potente e multimodale, ma anche spiegabile e controllabile,

- contenuti generati dagli algoritmi sempre migliori, fatti di testo ed immagini.. ma i video non si faranno attendere per molto,

- la possibilità di creare contenuti in base al contesto, ma anche ai dati dell'utente (personalizzazione dell'esperienza).

La costante, in tutto questo, sarà l'approccio "human in the loop": le persone rimarranno determinanti nel nostro lavoro, perché l'AI va intesa come strumento che potenzia le nostre capacità.

I SEO e i copywriter di domani padroneggeranno le tecnologie affrontate in questo post, e grazie a questo potranno spostare l’effort sulla qualità dell'output.

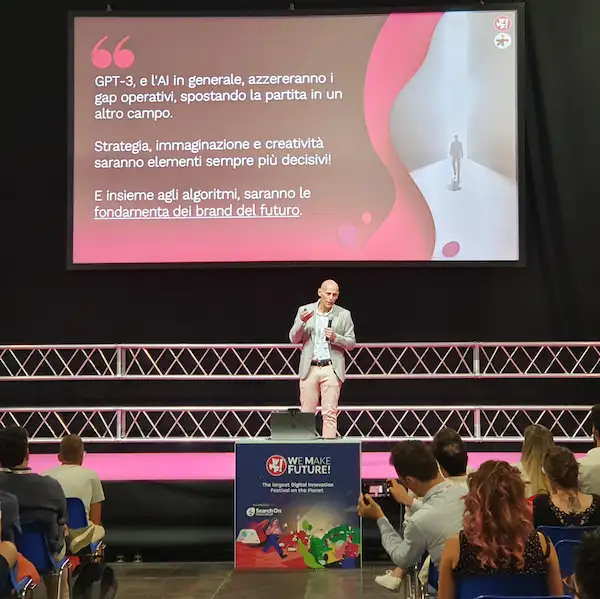

GPT-3, a l'AI in generale, azzereranno i gap operativi, spostando la partita in un altro campo. Un campo in cui strategia, immaginazione e creatività saranno sempre più elementi decisivi! E insieme agli algoritmi, rappresenteranno le fondamenta dei brand del futuro.

Una nuova estensione di Chrome per Connect.gt

Nell'ultima giornata di WMF si è svolto il raduno della community di Connect.gt, uno dei più importanti riferimenti per la formazione e la condivisione su tematiche relative al digital marketing, allo sviluppo e all'innovazione tecnologica.

Durante l'evento, insieme a Giorgio Taverniti e Andrea Dragotta, ho presentato la versione beta dell'estensione di Chrome dedicata alla community, sviluppata insieme a Carlo Cantarello: un carissimo amico e Salesforce Developer di Jakala.

L'estensione permetterà agli utenti di Connett.gt di autenticarsi e visualizzare il feed dei post direttamente dal browser. La funzionalità primaria, tuttavia, consentirà di selezionare del testo in qualunque pagina web, e di condividerlo direttamente nella piattaforma linkando l'origine dell'informazione.

Come si vede dalle immagini, l'azione di condivisione fa aprire un'interfaccia che consente la formattazione del testo, la selezione della categoria, la modifica del titolo (che viene generato automaticamente).

WMF 2022: un evento spettacolare

L'edizione di quest'anno è stata davvero incredibile. Non che le precedenti lo fossero meno.. ma questa profumava di cambiamento importante.

36.000 Vite.

Ogni volta che disegno il format del WMF, non penso a come strutturare un evento, ma a come render piena una vita. Una vita che abbia la durata di 3 giorni e che al termine lasci qualcosa di migliore per le generazioni future.

Questa volta spero che il nostro lavoro abbia reso realmente piene 36.000 vite e abbia contribuito a migliorare il futuro del nostro Paese.

- Cosmano Lombardo, Founder e Ideatore di WMF -

Per approfondire